AIモデルを扱うWindows開発者にとって朗報です:Docker Model RunnerがWindows Dockerデスクトップ上でWSL2 とNVIDIA GPUを搭載したvLLMをサポートしました!

これまで、Docker Model Runnerの vLLMサポート はLinux上のDocker Engineに限定されていました。このアップデートにより、Windows開発者はDocker Desktopを通じてvLLMの高スループット推論機能を直接活用し、NVIDIA GPUを活用してローカルAI開発を加速させることができます。

Docker Model Runnerとは何ですか?

まだ試していない方のために説明すると、Docker Model Runnerは私たちの新しい「ただ動く」生成AIモデルの体験です。

私たちの目標は、コンテナを動かすのと同じくらいモデルの実行を簡単にすることです。

この作品の素晴らしい点は以下の通りです:

- シンプルなUX: プロセスを直感的な単一のコマンドに絞りました:docker model run <model-name>。

- 幅広いGPUサポート: NVIDIAから始めましたが、最近 Vulkanのサポートも追加しました。これは大きな出来事です。Model RunnerはAMDやIntelを含む ほぼすべての最新GPUで動作し、AIをこれまで以上に多くの開発者が利用できるようになっています。

- vLLMの: NVIDIA GPUで高スループット推論を行う

vLLMとは何ですか?

vLLMは大規模言語モデル向けの高スループット推論エンジンです。KVキャッシュの効率的なメモリ管理を目的としており、同時リクエストの処理に優れたパフォーマンスを発揮します。複数のリクエストに対応する必要があるAIアプリケーションや高スループットの推論が必要な場合、vLLMは優れた選択肢です。詳しく はこちらをご覧ください。

前提 条件

始める前に、 GPU対応の前提条件を揃えていることを確認してください:

- Docker Desktop for Windows(Docker Desktop 4から始まる。54)

- Docker DesktopでWSL2 バックエンドを有効にしています

- 計算能力を備えた最新のドライバーを備えたNVIDIA GPU >= 8。0

- Docker Desktopで設定されたGPUサポート

始める

ステップ 1:Docker Model Runnerを有効にする

まず、Docker DesktopでDocker Model Runnerが有効になっていることを確認してください。これはDocker Desktopの設定またはコマンドラインから行えます:

docker desktop enable model-runner --tcp 12434

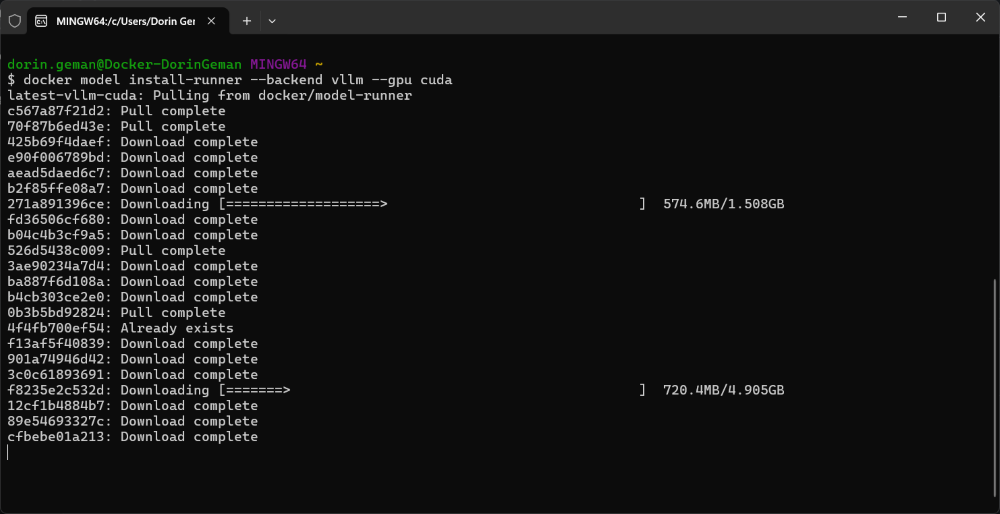

ステップ 2:vLLMバックエンドをインストールする

vLLMを使用するには、CUDA対応のvLLMランナーをインストールしてください:

docker model install-runner --backend vllm --gpu cuda

ステップ 3:設置の確認

両方の推論エンジンが稼働しているか確認してください:

docker model install-runner --backend vllm --gpu cuda

以下のような出力が見られるはずです:

Docker Model Runner is running

Status:

llama.cpp: running llama.cpp version: c22473b

vllm: running vllm version: 0.12.0

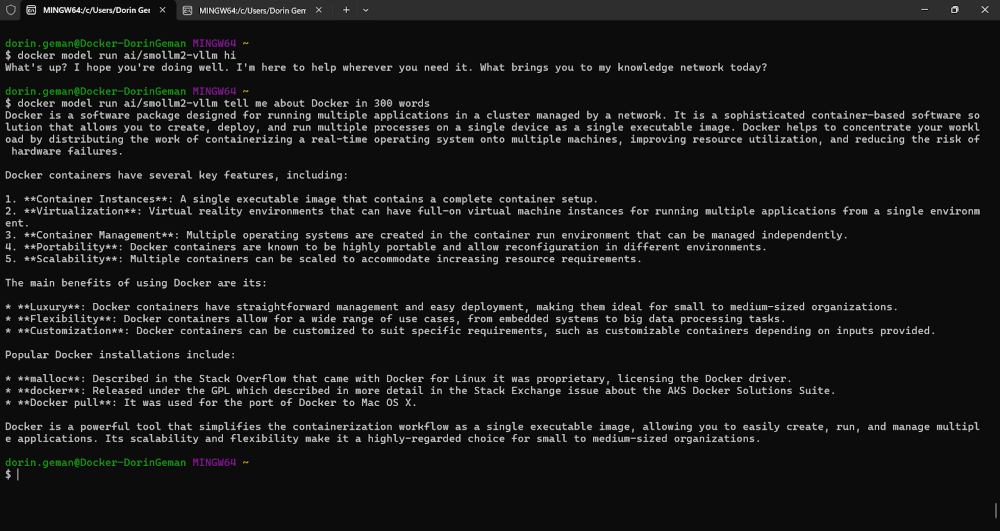

ステップ 4:vLLMでモデルを実行する

これでvLLMに最適化されたモデルをプルして実行できます。Docker Hubで -vllm サフィックスが付いたモデルはvLLM向けにパッケージ化されています:

docker model run ai/smollm2-vllm "Tell me about Docker."

トラブルシューティングのヒント

GPUメモリの問題

もし次のようなエラーに遭遇したら:

ValueError: Free memory on device (6.96/8.0 GiB) on startup is less than desired GPU memory utilization (0.9, 7.2 GiB).

GPUメモリの使用率は特定のモードに設定できます:

docker model configure --gpu-memory-utilization 0.7 ai/smollm2-vllm

これによりメモリ使用量が削減され、モデルは他のGPUワークロードと並行して動作することが可能になります。

なぜこれが重要なのか

このアップデートはWindows開発者にとっていくつかの利点をもたらします:

- 本番パリティ:本番環境で使うのと同じ推論エンジンでテストします

- 統一ワークフロー:すでに知っているDockerエコシステム内に留まる

- ローカル開発:開発中のデータをプライベートに保ち、APIコストを削減します

参加方法

Docker Model Runnerの強みはコミュニティにあり、成長の余地は常にあります。このプロジェクトを最高のものにするために、皆さんのご協力が必要です。参加するには、以下の方法があります:

- リポジトリに星をつける: Docker Model Runnerリポジトリに星をつけて、私たちの認知度を高めるためにご支援いただければ幸いです。

- アイデアを投稿してください。 新機能やバグ修正のアイデアはありますか?問題を作成して議論します。または、リポジトリをフォークし、変更を加えて、pull request を送信します。私たちはあなたがどんなアイデアを持っているかを見るのを楽しみにしています!

- 言葉を広める: 友人、同僚、および Docker で AI モデルを実行することに興味がある可能性のある人に伝えてください。

私たちは Docker Model Runner のこの新しい章に非常に興奮しており、一緒に何を構築できるかを見るのが待ちきれません。さあ、仕事に取り掛かりましょう!