内部脅威は常に管理が難しいものでした。なぜなら、信頼されたアクセスとリスク行動の境界を曖昧にしてしまうからです。

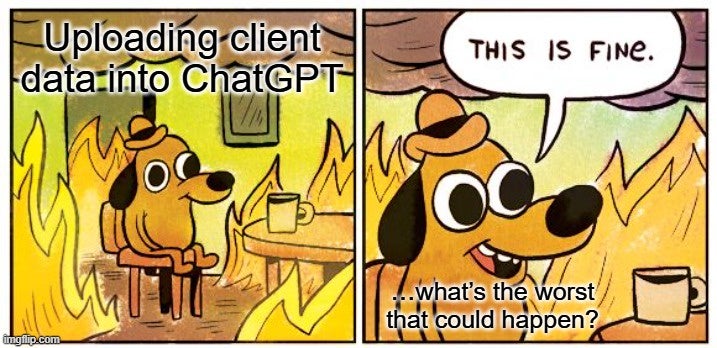

生成AIでは、これらのリスクは悪意ある内部者が認証情報を悪用したり、管理を回避したりすることに起因しません。それは善意の従業員が単に仕事を早く終わらせたいだけなのです。開発者がコードをリファクタリングしたり、アナリストが長いレポートをまとめたり、マーケターがキャンペーンを起草したりと、その根本的な動機はほぼ常に生産性と効率性にあります。

残念ながら、まさにそれがこのリスクの管理を非常に困難にしています。従業員は自分たちがセキュリティ上の問題を生んでいるとは考えていません。彼らはボトルネックを解決しています。セキュリティはせいぜい後回しにされる程度です。

この認識のギャップが失敗の機会を生み出します。ITやセキュリティチームがAIツールが広く採用されていることに気づく頃には、リスクの高い使用パターンがすでにワークフローに深く根付いている可能性があります。

現在、職場でのAI利用はやや自由奔放な状態です。みんなが「楽しいよ」「みんなやってる」と言うと、まるで高校時代に戻ったような気分になります。誰もリスクがあるからやめろと言う人になりたくないのです。

しかし、警備として責任はあります。

この記事では、管理されていないAI使用のリスク、既存のセキュリティアプローチがなぜ不十分であるのか、そしてユーザーの熱意と責任感のバランスを取るためにできることを提案します(パーティーの邪魔にならずに)。

リスクの高いAI利用の例

職場でのAI使用のリスクは通常、以下の3つのカテゴリーのいずれかに分類されます。

- 機密データ漏洩:単一の貼り付けた文字起こし、ログ、APIキーは軽微に思えるかもしれませんが、会社の範囲外に出ると事実上消え、プロバイダーの保持と分析の対象となります。

- 知的財産の漏洩:独自コード、設計、研究草案がAIツールに入力されると、トレーニングデータになったり、プロンプトインジェクションで露出した場合、競争優位性が侵食される可能性があります。

- 規制およびコンプライアンス違反:HIPAA、GDPRなどの規制されたデータを非公認のAIシステムにアップロードすると、違反が起きなくても罰金や法的措置が発生する可能性があります。

これらのリスクを特に困難にしているのは、その微妙さにあります。それらは日常のワークフローから生まれ、明らかなポリシー違反ではなく、被害が起こるまで気づかれないことが多いのです。

シャドウAI

長年にわたり、 シャドウIT とは非公式のSaaSアプリ、メッセージングプラットフォーム、ファイルストレージシステムを指してきました。

生成AIは今やこのカテゴリーにしっかりと属しています。

従業員は、 ChatGPT のようなチャットボットにテキストを貼り付けることが、企業に新しいシステムを導入するとは思っていません。しかし実際には、監督や記録、契約上の保護なしにデータを外部環境に移しています。

Shadow AIが異なるのは可視性の欠如です。過去の技術とは異なり、セキュリティチームが追跡すべき明確なログやアカウント、アラートを残さないことが多くあります。クラウドファイル共有により、セキュリティチームはアップロードの追跡、企業メールで作成されたアカウントの監視、不審なネットワークトラフィックの検出などが可能になります。

しかし、AIの使用はしばしば通常のブラウザ活動のように見えます。また、一部のセキュリティチームは従業員がウェブフォームに貼り付けた内容をスキャンしますが、その管理は限られています。

ここで本当の問題は、AIの使用を適切に管理するためのツールが実際には存在しないということです。少なくとも今のところは。

操作性が不足しています

私たちは皆、仕事を早く終わらせようとする人々を見かけますし、何らかの防護措置を設けるべきだと分かっていますが、選択肢は高価で複雑か、まだ模索中です。

利用可能な わずかなAIガバナンス およびセキュリティツールには明確な制限があります(マーケティング上はそうではないと説得しようとするかもしれませんが):

- 新興のAIガバナンスプラットフォームは、利用状況の監視、ポリシーの執行、機密データのガードレールを提供しますが、多くの場合、高価で複雑で、または限定的です。

- 従来のDLPや XDR などの管理は電話番号、ID、内部顧客記録などの構造化データを捉えますが、ソースコード、独自アルゴリズム、戦略文書など、より微妙で検出が難しい情報には苦労します。

これらのツールがあっても、AI導入のスピードはセキュリティチームが遅れを取る状況を生み出しています。現実には、管理は改善されていますが、従業員がAIをどれほど早く探索しているかにはほとんど追いついていません。

過去のセキュリティの盲点からの教訓

新しいツールを使いながら、セキュリティチームが追いつこうと慌てている従業員は、クラウドファイル共有の初期と大きく変わりません。IT部門が承認するソリューションがなかった頃、従業員はDropboxやGoogle Driveに殺到していました。また、「 持ち込み端末( BYOD)」の台頭を思い出してください。個人の携帯電話やノートパソコンが明確なポリシーなしに企業ネットワークに接続し始めた時代です。

両運動とも生産性を約束しましたが、同時にセキュリティチームが遡及的に管理するのが難しいリスクも生み出しました。

生成AIはこのパターンを、ただしはるかに速いペースで繰り返しています。クラウドツールやBYODは設定や少なくとも個人デバイス接続の決定が必要ですが、AIツールはブラウザ上で即座に利用可能です。参入障壁はほぼゼロです。つまり、セキュリティリーダーが気づく前に導入が組織全体に広がってしまうのです。

そしてクラウドやBYODと同様に、その順序は馴染み深いものです。まず従業員の導入が始まり、その後に管理が続き、遡及的な措置はほとんどの場合、よりコストが高く、扱いにくく、積極的なガバナンスよりも効果的ではありません。

では、私たちは何ができるのでしょうか?

覚えておいてください:AI駆動のインサイダーリスクは悪意のある人ではなく、善良な人々が生産的かつ効率的になろうとするものです。(まあ、まあ、少し怠けたものも少し混ぜておけば。)残念ながら、悪意のある行動ではなく、不必要な露出を生んでいるのは普通の行動です。

つまり、すべての組織が即座に実施できる一つの施策があります。それは従業員の教育です。

教育は実践的で共感できるものが最も効果的です。「コンプライアンスチェックボックス」というより、「おそらく経験したことがあるシナリオ」を考えてみてください。それがぼんやりとした意識から実際の行動の変化へと移行する方法です。

ここに、実際に違いを生む3つのステップをご紹介します。

- 実際の事例で認知度を高めましょう。コードや顧客情報、計画案をチャットボットに貼り付けることが、公開するのと同じ効果をもたらすことを示しましょう。それが多くの人に必要な「なるほど」の瞬間です。

- 所有権を強調しましょう。従業員はすでにパスワードの使い回しや怪しいリンクをクリックしないことを知っています。AIの使用も同じ個人の責任という枠組みで捉えるべきです。目標は、単にルールに従うだけでなく、会社を守っていると感じられる文化を作ることです。

- はっきりとした境界線を設けましょう。どのデータカテゴリが禁止されているか、 個人情報、ソースコード、未公開製品、規制された記録などを明確に示し、社内AIサンドボックスのような安全な代替手段を提供しましょう。明確さは推測を減らし、利便性の誘惑を排除します。

ガバナンスツールが成熟するまでは、これらの低摩擦のステップが私たちの最も強力な防御策となります。

AIの生産性を活用しつつ、重要なデータを保護できれば、今日のリスクを減らせます。そして、必ず続く規制や監督に備えることができます。