こんにちは、ベルリン在住のDockerキャプテン兼リードソフトウェアエンジニアであるSergei Shitikovです。私は、DevOps、開発者エクスペリエンス、オープンソース、ローカルAIツールに焦点を当てています。この拡張機能は、技術的なバックグラウンドがなくても、Docker Model Runner と Open WebUI を使用してローカル LLM を誰でも簡単に使い始められるようにするために作成されました。

この新しい Docker 拡張機能を使用すると、Open WebUI の背後にある推論サービスとして Docker Model Runner を実行し、より豊富なチャット エクスペリエンスを強化できます。このブログでは、Docker Model Runner と Open WebUI が強力なデュオになる理由、独自のローカル AI アシスタントを設定する方法、内部で何が起こっているかについて説明します。

ローカル LLM はもはや単なる実験的なおもちゃではありません。モデル最適化の急速な進歩とますます強力なコンシューマー ハードウェアのおかげで、ローカルの大規模言語モデルは概念実証の好奇心から真に便利なツールになりました。

M シリーズ チップを搭載した MacBook でも、インターネット接続や API キーなしで、オフラインで高速で有意義な応答を提供するモデルを実行できるようになりました。

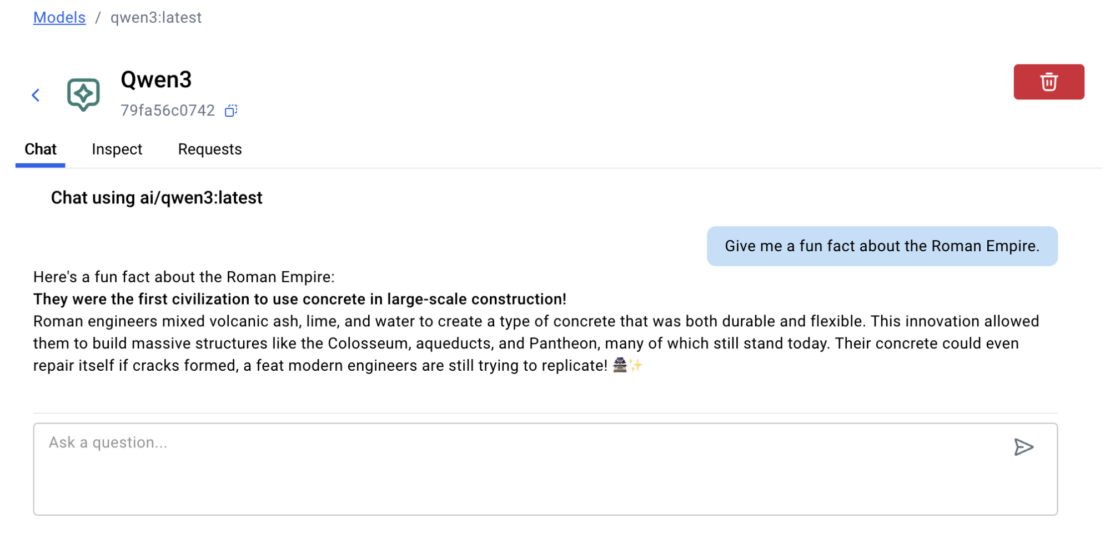

Docker Desktop からアクセスできる Docker Model Runner (Docker CE のプラグインとしても利用可能であり、もちろん完全な OSS も利用可能) により、UI でモデルを選択するか、CLI から 1 つのdocker model runを実行するだけで簡単に開始できます。

完全に運用可能なモデルを数秒で稼働させることができます。

Docker Model Runner + Open WebUI: よりリッチなローカル AI チャット エクスペリエンスを実行するための強力なデュオ

Docker Model Runner は、Docker Desktop または CLI の推論サービスとして設計されており、開発者は信頼して知っている使い慣れたワークフローとコマンドを使用してモデルをローカルで実行できます。つまり、設計の観点からは、プロンプトボックスと応答フィールドという最低限のものしか提供されません。記憶がない。ファイルのアップロードはありません。チャットフローはありません。本物のアシスタントのように感じるインターフェースはありません。これは実際には仕様によるものであることに注意してください。Docker Desktop 内でエクスペリエンスを複製する意図はありません。これは、より広範なエコシステム内の他の製品によってすでに十分に実装されています。

そこで登場するのが、ローカル LLM を操作するために特別に設計された最新のセルフホスト型インターフェイスである Open WebUI です。

チャット履歴、ファイルのアップロード、プロンプト編集などを提供します。すべてローカル。すべてプライベート。

そのため、この 2 つを組み合わせる拡張機能が作成されました。

この Docker 拡張機能 は Open WebUI を起動し、Docker Model Runner を介して実行中のモデルに直接フックします。設定なし。セットアップなし。開いて行くだけです。

それがどのように機能するか見てみましょう。

ゼロからローカルAIアシスタントまで数回クリックで

Docker Desktop が既にインストールされている場合は、ほぼ完了です。

[ モデル] タブに移動し、Docker Hub セクションから任意のモデルを選択します: GPT-OSS、Gemma、LLaMA 3、Mistral など。

ワンクリックで、Docker Model Runner がコンテナをプルし、ローカルでモデルの提供を開始します。

CLI を好みますか?1 つの docker model pull で同じ仕事をします。

次に、単一の入力ボックスよりも高性能なものが必要になる場合があります。

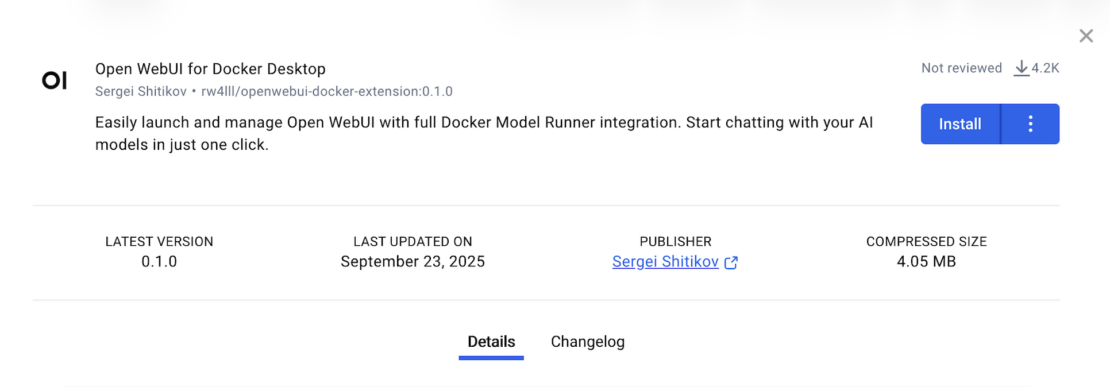

Docker Desktop 内で Extensions Marketplace を開き、ローカル LLM 用の機能豊富なインターフェイスである Open WebUI 拡張機能をインストールします。

コンテナーが自動的にプロビジョニングされ、 ローカルの Docker Model Runner に接続されます。

ダウンロードしたすべてのモデルが WebUI に表示され、すぐに使用できます。手動設定、環境変数、ポートマッピングはありません。

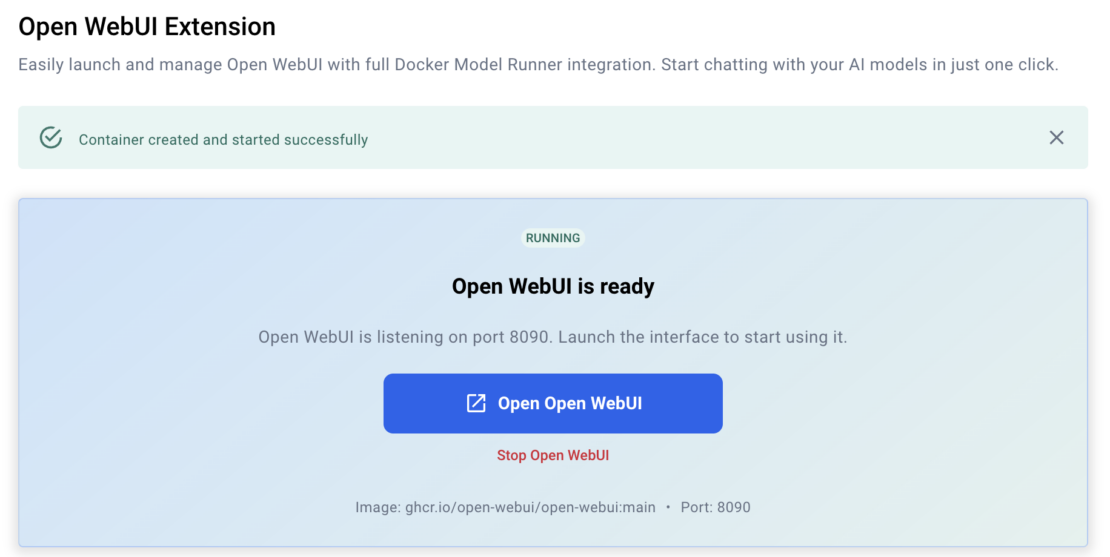

セットアップが完了すると、拡張機能が実行されていることを確認する画面と、ブラウザでインターフェイスを起動するためのボタンが表示されます。

または、 http://localhost:8090 (デフォルトポート) で手動で開くか、後で使用するためにブックマークすることもできます。

手記: Open WebUI は必要なコンポーネントをインストールし、統合を構成するため、初回の起動には数分かかる場合があります。

その後の打ち上げははるかに高速で、ほぼ瞬時に行われます。

Open WebUIでできること

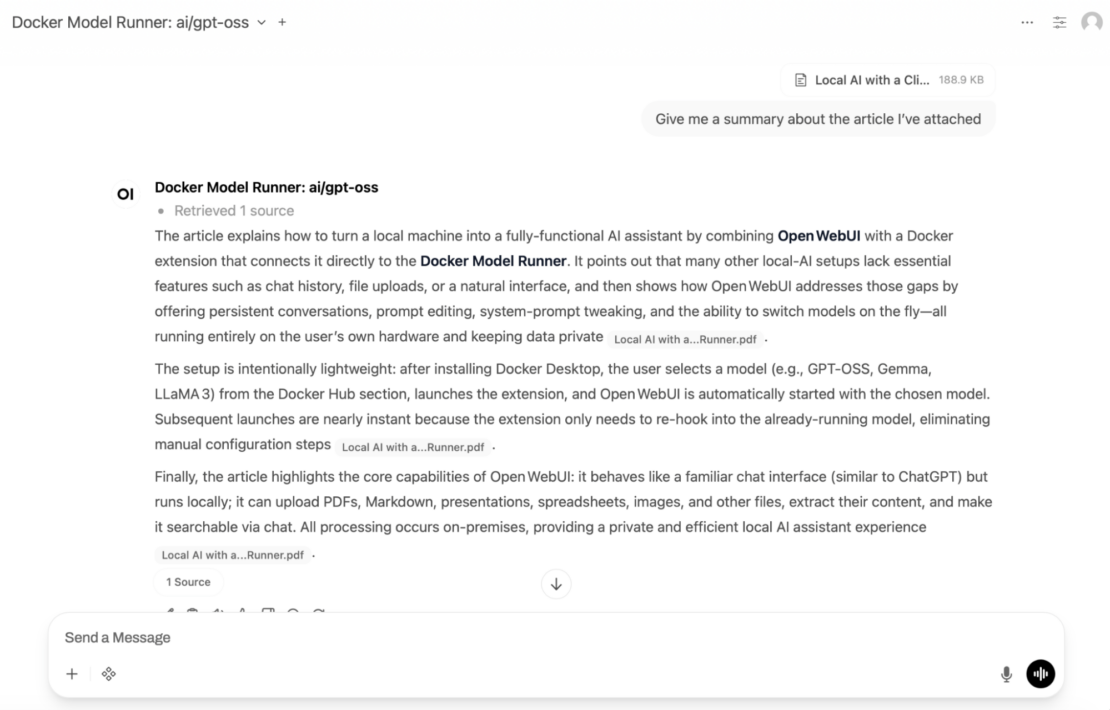

インストールすると、Open WebUI は ChatGPT を使用しているかのようにすぐに親しみやすく感じられますが、完全に自分のマシン上で実行されます。

永続的な会話、システムプロンプトの編集、その場でモデルを切り替える機能など、完全なチャット体験が得られます。

ファイルをアップロードしてチャットする

PDF、Markdownファイル、プレゼンテーション、スプレッドシート、さらには画像をドロップします。

Open WebUI はコンテンツを抽出し、チャットを通じてクエリできるようにします。

概要、クイック回答、またはコンテンツの概要が必要ですか?聞いてみてください:すべての処理はローカルで行われます。

タイプではなく話す

音声入力をオンにすると、ブラウザから直接アシスタントと話すことができます。

これは、ハンズフリーのタスク、簡単なプロンプト、またはローカル AI セットアップを友人にデモンストレーションするのに最適です。

マイクにアクセスするには権限の設定が必要です。

モデルの動作を定義する

Open WebUI は、テンプレート、変数、チャットプリセットを使用してシステムプロンプトを完全に制御することをサポートします。

コードの下書き、ブログ投稿の執筆、電子メールへの返信など、モデルがどのように考え、応答するかを微調整できます。

モデルを瞬時に切り替える

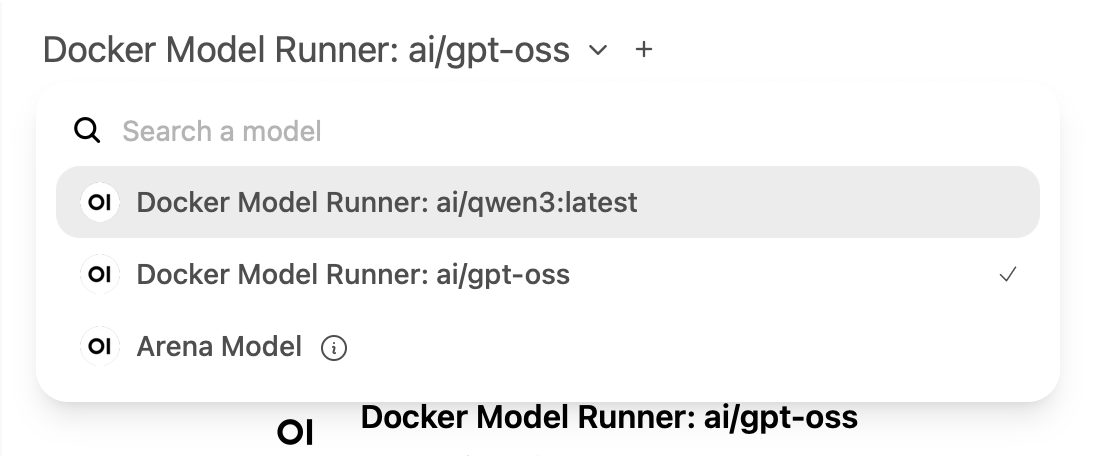

Docker Model Runnerを使用して複数のモデルをすでにダウンロードしていますか?

Open WebUI はそれらを自動的に検出します。ドロップダウンから任意のモデルを選択して、チャットを開始します。再起動は必要ありません。

インサイトをメモリに保存する

モデルに特定のことを記憶させたいですか?

ファクトやリマインダーは、個人用メモリパネルに手動で保存し、いつでも編集または削除できます。

もっとできること

Open WebUIは、実際のワークフローを強化する高度なツールを備えたチャットを超えています。

- 関数呼び出しとプラグイン

- 事前構築済みのツールを使用するか、Pipelines フレームワークを介して独自の Python 関数を定義して、自動化、翻訳、またはデータ検索に最適です。

- 多言語UI

- Open WebUI は幅広いインターフェイス言語をサポートしており、完全にローカライズ可能であるため、国際的なチームや英語以外のユーザーに最適です。

- 安全でローカルファーストの設計

- サインアップもクラウドストレージも不要です。すべてはあなたのマシンにとどまり、あなたの管理下にあります。

注: すべての機能が普遍的に利用できるわけではありません。一部は、モデルの機能(関数呼び出し、画像理解など)、現在のOpen WebUI設定(音声入力、プラグインなど)、または実行しているハードウェア(GPUアクセラレーション、ローカルRAGパフォーマンスなど)によって異なります。

Open WebUI は柔軟なプラットフォームを提供することを目的としていますが、実際の機能はセットアップによって異なる場合があります。

内部の仕組み

内部的には、この拡張機能には、Open WebUI と Docker Model Runner の統合と、Docker 拡張機能に組み込まれた動的コンテナ プロビジョナーという 2 つの重要なコンポーネントが統合されています。

Open WebUIは、モデルの動作を拡張する軽量プラグインであるPythonベースの「関数」をサポートしています。

この拡張機能には、ローカル API を介して Docker Model Runner に接続する関数が含まれており、インターフェイスはダウンロードしたすべてのモデルを自動的に一覧表示してアクセスできます。

拡張機能をインストールすると、Docker はオンデマンドで Open WebUI コンテナーをスピンアップします。これは静的なセットアップではなく、コンテナーは環境に基づいて動的に構成されます。できます:

- 別の Open WebUI イメージ (CUDA 対応または特定のバージョンなど) に切り替える

- デフォルトポートの変更

- カスタム環境と高度なフラグのサポート – 近日公開予定

拡張機能はこれらすべてを舞台裏で処理しますが、必要に応じて完全に制御できます。

結論

Docker Open WebUI 拡張機能が、Docker Model Runner を単純なモデル ランチャーから、メモリ、ファイル アップロード、マルチモデル サポートなどを備えたフル機能のローカル AI アシスタントに変える方法を見てきました。

以前はカスタム構成、手動ポート、またはサードパーティのスクリプトが必要だったものが、数回クリックするだけですぐに動作するようになりました。

次のステップ

- Docker Desktop Marketplaceから Open WebUI拡張機能 をインストールする

- Docker Model Runner 経由でモデルをダウンロードします (例: GPT-OSS、Gemma、LLaMA 3、Mistral)

http://localhost:8090でインターフェイスを起動し、ローカルでチャットを開始します- 高度な機能を調べる:ファイルチャット、音声入力、システムプロンプト、知識、プラグイン

- セットアップを変更せずにいつでもモデルを切り替えたり、新しいモデルを試したりできます

ローカル AI の未来は、モジュール式でプライベートで使いやすいものです。

この拡張により、私たちはそのビジョンに一歩近づきましたが、まだ始まったばかりです。

参加する

- GitHub の Open WebUI Docker 拡張機能にスターを付けるか、投稿する

- Docker Extensions Marketplace の更新プログラムとリリースをフォローする

- Docker Model Runner リポジトリへの貢献: オープンソースでコミュニティ主導型です

- フィードバックやユースケースをDockerおよびOpen WebUIコミュニティと共有する