Goose は、AIモデルを使用して開発タスクを自動化するように設計された革新的なCLIアシスタントです。Docker Model Runner は、Docker を使用して AI モデルをローカルにデプロイするのを簡素化します。これらのテクノロジーを組み合わせることで、高度なAI支援を備えた強力なローカル環境が生まれ、コーディングや自動化に最適です。

プライバシーや柔軟性を損なうことなく、AIを活用した開発タスクをローカルでシームレスに実行する方法をお探しですか?もう探す必要はありません。CLI ベースの AI アシスタントである Goose と Docker Model Runner を組み合わせることで、大規模な言語モデルをマシン上で実行するための、開発者にとって使いやすい合理化されたセットアップを実現できます。

Docker Model Runner を使用すると、Docker を使用してオープンソースの AI モデルを簡単に実行でき、クラウド API や外部依存関係は必要ありません。そして、一番の魅力は?OpenAI互換のインターフェースを期待するGooseのようなツールで、箱から出してすぐに動作します。つまり、インテリジェントなチャットだけでなく、タスクの自動化、コードの実行、システムとの対話を行う高度なローカルアシスタントをスピンアップでき、データを他の場所に送信せずに済みます。

このガイドでは、これらの革新的なツールを使用して独自のAIアシスタントを構築する方法を学びます。Goose のインストール方法、Docker Model Runner と連携するように設定する方法、実際の開発者ワークフローを強化できるプライベートなスクリプト可能な AI アシスタントを解き放つ方法について説明します。1 回限りのコマンドを実行する場合でも、定期的な自動化をスケジュールする場合でも、このローカルファーストのアプローチにより、制御を維持し、物事をより迅速に完了できます。

Goose CLIをmacOSにインストールする

Gooseは 、Windows、macOS、およびLinuxで コマンドラインツールとして利用でき、必要に応じてmacOS用のデスクトップアプリケーションもあります。この記事では、macOSでCLIバージョンを構成して表示します。

Gooseをインストールするには、この便利なカール2sudo onelinerテクニックを使用できます。

curl -fsSL https://github.com/block/goose/releases/download/stable/download_cli.sh | bash

Docker Model Runner を有効にする

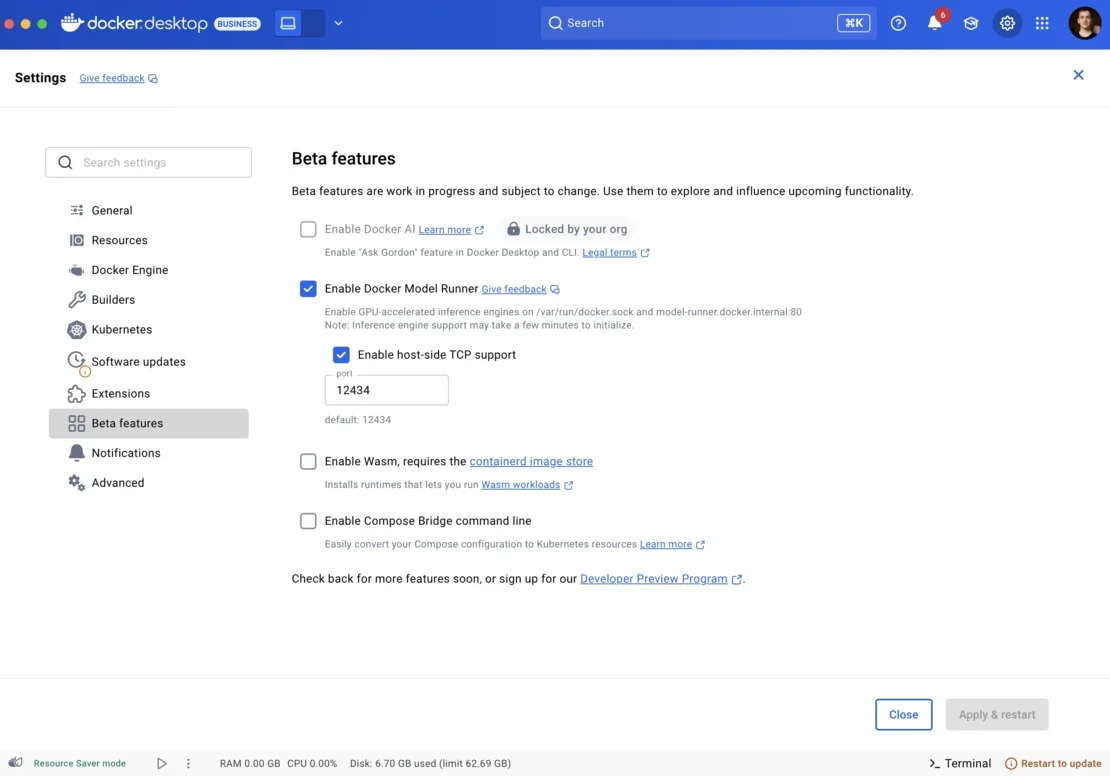

まず、 Docker Desktop がインストールされていることを確認します。次に、選択したモデルで Docker Model Runner を構成します。Settings > Beta featuresに移動し、Docker Model Runner のチェックボックスをオンにします。

デフォルトでは、セキュリティ上の予防措置として、ホストマシンから使用できるように配線されていませんが、セットアップを簡素化し、TCPサポートも有効にしたいと考えています。デフォルトのポートは 12434であるため、接続のベース URL は次のようになります。 http://localhost:12434

図1:ポート12434を有効にする方法を示すDockerDesktopベータ版の機能設定

これで、Docker Hubからモデルを取得できます hub.docker.com/u/aiモデルを実行します。この記事では、 ai/qwen3:30B-A3B-Q4_K_M を使用して、 3B のアクティブ パラメーターだけで世界の知識とインテリジェンスのバランスが取れているため、これを使用します。

docker model pull ai/qwen3:30B-A3B-Q4_K_M

docker model run ai/qwen3:30B-A3B-Q4_K_M

このコマンドは、モデルとの対話型チャットを開始します。

Goose を Docker Model Runner 用に構成する

Gooseの設定を ~/.config/goose/config.yamlで編集します。

GOOSE_MODEL: ai/qwen3:30B-A3B-Q4_K_M

GOOSE_PROVIDER: openai

extensions:

developer:

display_name: null

enabled: true

name: developer

timeout: null

type: builtin

GOOSE_MODE: auto

GOOSE_CLI_MIN_PRIORITY: 0.8

OPENAI_API_KEY: irrelevant

OPENAI_BASE_PATH: /engines/llama.cpp/v1/chat/completions

OPENAI_HOST: http://localhost:12434

Docker Model Runner は、モデルがマシン上でローカルおよびプライベートに実行されるため、認証を必要としないため、 OPENAI_API_KEY は関係ありません。

OpenAI互換APIのベースパスを提供し、以前にプルしたモデル GOOSE_MODEL: ai/qwen3:30B-A3B-Q4_K_M を選択します。

テストする

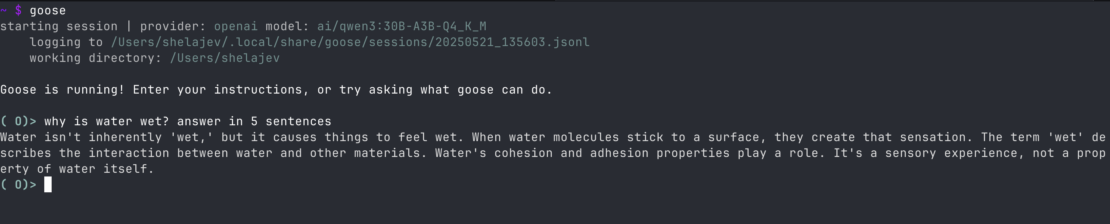

ターミナルでgooseを実行して、Goose CLIを試してください。正しいモデルに自動的に接続され、何かを求めるとGPUのスパイクも表示されます。

図 2:ターミナルで実行されているGoose CLI、ローカルプロンプトへの応答の例を示しています

次に、Developer拡張機能を有効にするようにGooseも構成します。これにより、ユーザーに代わってさまざまなコマンドを実行でき、単なるチャットアプリケーションよりもマシンにアクセスできるはるかに強力なアシスタントになります。

さらに、Gooseのカスタムヒントを設定して、.goosehintsを使用してその動作を微調整できますファイル。

さらに良いことに、Gooseは簡単なワンライナーであなたに代わってタスクを実行するようにスクリプト化できます。

goose run -t "your instructions here" 又は goose run -i instructions.md

ここで、 instructions.md は何をすべきかを示すファイルです。

macOSでは、繰り返しスクリプトをスケジュールするためにcrontabにアクセスできるため、Docker Model Runnerを使用してGooseを自動化し、繰り返しアクティブ化してユーザーに代わって行動させることができます。たとえば、 crontab -e と入力すると、実行したいコマンドのエディターが開き、次のような行でうまくいくはずです。

5 8 * * 1-5 goose run -i fetch_and_summarize_news.md

Gooseを 8時:毎日午前05 時に実行し、 fetch_and_summarize_news.md ファイルの指示に従ってください。たとえば、インターネットをざっと見て、好きなものに基づいてニュースに優先順位を付けます。

結論

全体として、Goose を Docker Model Runner と統合すると、ワークフローにローカル AI を使用するためのシンプルかつ強力なセットアップが作成されます。

カスタム命令を実行させることも、反復的なアクションをインテリジェントに実行するように簡単にスクリプト化することもできます。

これはすべて、Docker Model Runnerで実行されるローカルモデルによって駆動されるため、プライバシーにも妥協しません。

さらに詳しく

- Docker Model Runner のクイックスタートガイドをお読みください。

- Model Runner のドキュメントが見つかります。

- Docker Navigator ニュースレターを購読してください。

- Docker は初めてですか? アカウントを作成します。

- ご質問はございますか? Docker コミュニティがお手伝いします。