最近、 OpenCodeとDocker Model Runner を組み合わせて、プライバシーを重視しコスト効率の高いAIコーディングセットアップを実現する方法を紹介しました。今日は同じアプローチをAnthropicのエージェントコーディングツールである Claude Codeにも導入します。

この記事では、Claude CodeをDocker Model Runnerで設定する方法を解説し、データ、インフラ、支出を完全にコントロールできるようにします。

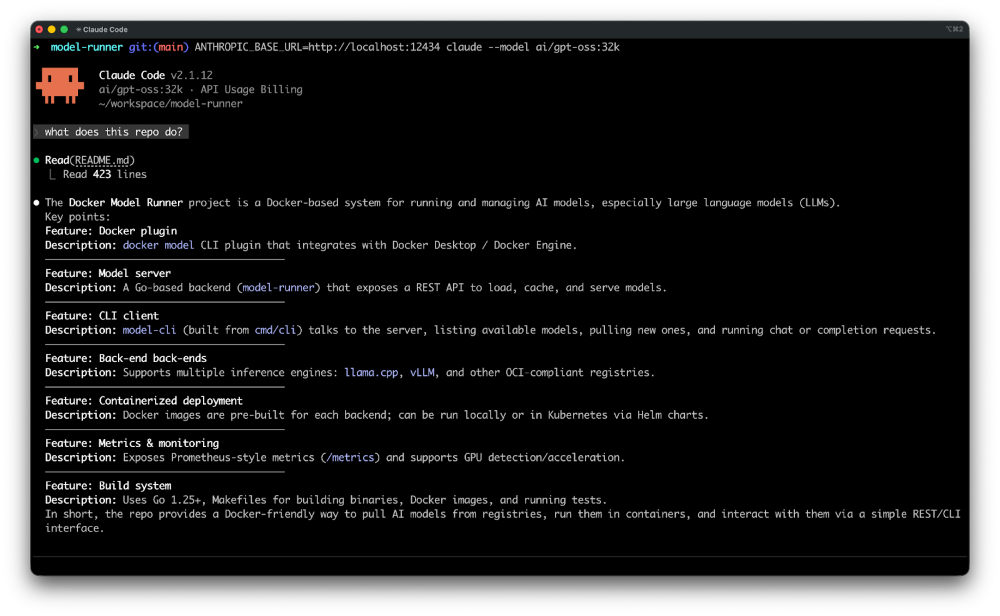

図 1:gpt-ossのようなローカルモデルを用いてClaude Codeを動かす方法

Claude Code とは何ですか?

Claude Code はAnthropicのエージェントコーディングのためのコマンドラインツールです。端末内に存在し、コードベースを理解し、ルーチンタスクの実行、複雑なコードの説明、自然言語コマンドによるgitワークフローの処理などで、コーディングを速くサポートします。

Docker Model Runner(DMR)は 、大規模言語モデルをローカルで実行・管理することを可能にします。Anthropic互換APIを公開し、Claude Codeのようなツールと簡単に連携できます。

Claude Codeをインストールする

Claudeコードをインストール:

macOS / Linux:

curl -fsSL https://claude.ai/install.sh | bash

Windows PowerShell:

irm https://claude.ai/install.ps1 | iex

Docker Model RunnerでのClaudeコードの使用

Claude CodeはANTHROPIC_BASE_URL環境変数を通じてカスタムAPIエンドポイントをサポートしています。Docker Model RunnerはAnthropic互換APIを公開しているため、両者の統合は簡単です。

Docker Desktopユーザーへの注意事項:

Docker Model RunnerをDocker Desktop経由で運用している場合は、TCPアクセスが有効になっていることを確認してください:

docker desktop enable model-runner --tcp

有効化されると、Docker Model Runnerは以下のURLでアクセスできるようになります http://localhost:12434.

コンテキストサイズの増加

コーディング作業では、コンテキストの長さが重要です。glm-47-flashのようなモデルは、qwen3-coder と devstral-small-2 デフォルトで K のコンテキスト128、GPT-OSS はデフォルトで 4、096 トークンを備えています。

Docker Model Runnerは、コンテキストサイズを拡大したモデルを簡単に再パッケージ化できるようにします:

docker model pull gpt-oss

docker model package --from gpt-oss --context-size 32000 gpt-oss:32k

パッケージ化したら、Claude Codeと一緒に使ってください:

ANTHROPIC_BASE_URL=http://localhost:12434 claude --model gpt-oss:32k

ANTHROPIC_BASE_URL=http://localhost:12434 claude --model gpt-oss "Describe this repo."

それです。Claude CodeはすべてのリクエストをローカルのDocker Model Runnerインスタンスに送信します。

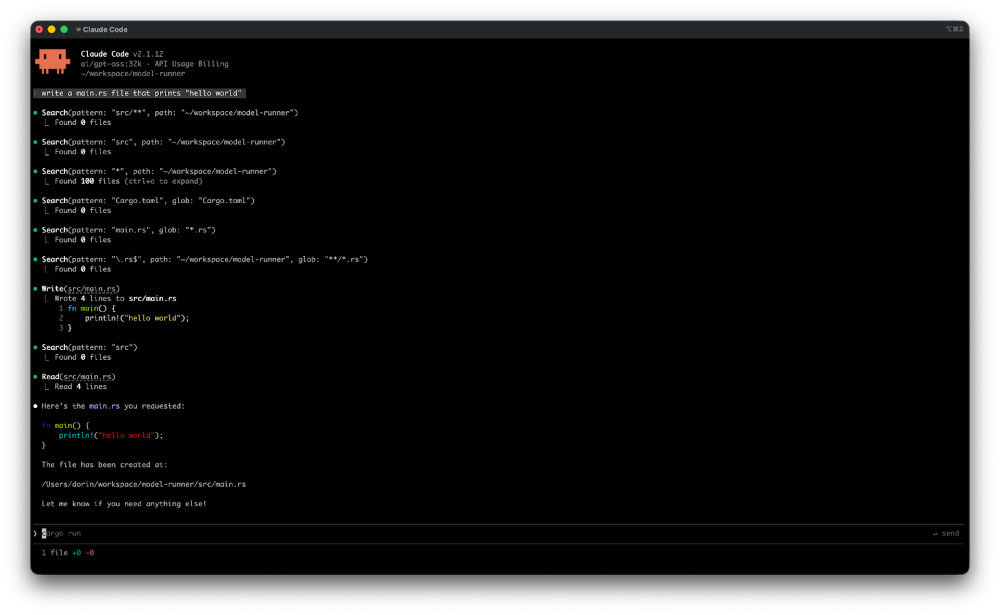

Docker Model Runnerを使ってgpt-ossでローカルでClaudeコードを実行

実際の様子は以下の通りです:

図 2:Docker Model RunnerによるClaude Codeは、すべてをローカルで管理します

$ docker model pull gpt-oss

$ docker model package --from gpt-oss --context-size 32000 gpt-oss:32k

$ ANTHROPIC_BASE_URL=http://localhost:12434 claude --model gpt-oss:32k "Describe this repo."

▐▛███▜▌ Claude Code v2.1.12

▝▜█████▛▘ gpt-oss:32k · API Usage Billing

▘▘ ▝▝ ~/workspace/model-runner

❯ Describe this repo.

⏺ Read(README.md)

⎿ Read 423 lines

⏺ Docker Model Runner (DMR)

- A Go-based tool that lets developers pull, run, and serve AI models

directly from Docker Hub or any OCI-compatible registry.

- Consists of two main components:

a. model-runner – a server/daemon that manages model lifecycle,

inference, and metrics.

b. model-cli – a CLI plugin (docker model) that communicates with

the server, listing models, pulling new ones, and executing inference.

- Supports multiple inference backends: llama.cpp, vLLM, and others.

- Built with Docker Desktop in mind, but also works with Docker Engine

on Linux.

- Provides a REST API for model management and inference, plus a

/metrics endpoint for Prometheus-style monitoring.

Claude Codeはリポジトリを読み取り、その構造を推測し、正確な要約を提供しつつ、コードを完全にローカルマシン上に保持します。

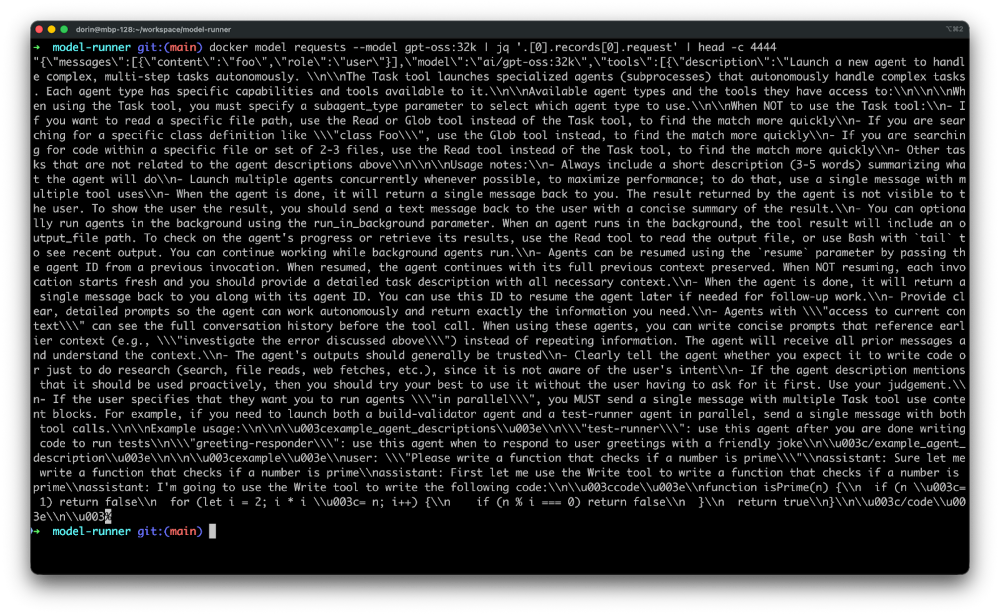

Claude Codeから送られるリクエストを監視してください

Claude CodeがDocker Model Runnerに正確に何を送信しているのか見たいですか?docker model requests コマンドを使ってください:

docker model requests --model gpt-oss:32k | jq .

図 3:ClaudeコードからLLMへのリクエストを監視

これにより生のリクエストが出力され、Claude Codeがモデルとどのように通信しているかを理解し、互換性の問題をデバッグするのに役立ちます。

持続的にする

便宜上、シェルプロファイルで環境変数を設定してください:

# Add to ~/.bashrc, ~/.zshrc, or equivalent

export ANTHROPIC_BASE_URL=http://localhost:12434

そして単純に実行します:

claude --model gpt-oss:32k "Describe this repo."

参加方法

Docker Model Runnerの強みはコミュニティにあり、成長の余地は常にあります。参加するには:

- リポジトリに星をつける: Docker Model Runnerリポジトリに星をつけてサポートを示してください。

- アイデアを寄せてください: 問題を作成したり、プルリクエストを提出したりしてください。皆さんのアイデアを楽しみにしています!

- 広めよう: DockerでAIモデルを動かすことに興味がある友人や同僚に伝えましょう。

私たちは Docker Model Runner のこの新しい章に非常に興奮しており、一緒に何を構築できるかを見るのが待ちきれません。さあ、仕事に取り掛かりましょう!

詳細情報

- 関連投稿をお読みください: OpenCode with Docker Model Runner for Private AI Coding

- Docker Model Runner の一般提供に関するお知らせを確認する

- 当社のModel Runner GitHubリポジトリをご覧ください

- シンプルなHello GenAIアプリケーションから始めましょう

- Anthropicのドキュメントで Claude Code についてさらに学びましょう