Docker では、コミュニティとコラボレーションの力を常に信じています。ロバート・アクセルロッドが 『The Evolution of Cooperation』で言った「うまくやる鍵は、他人に勝つことではなく、彼らの協力を引き出すことにある」という言葉を思い出します。そして、Docker Model Runner がこの協力関係を促進するのに、AI、ML、データ サイエンス コミュニティの有名な集いの場である Hugging Face が最適です。開発者は、Docker Model Runner をローカル推論エンジンとして使用して、Hugging Face でモデルを実行し、Model Runner がサポートするモデルをフィルタリングできることをお知らせします。

もちろん、Docker Model Runner は以前から Hugging Face リポジトリから直接モデルをプルすること をサポートしてきました。

docker model pull hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF

抱きしめている顔のモデルランナーによる局所推論

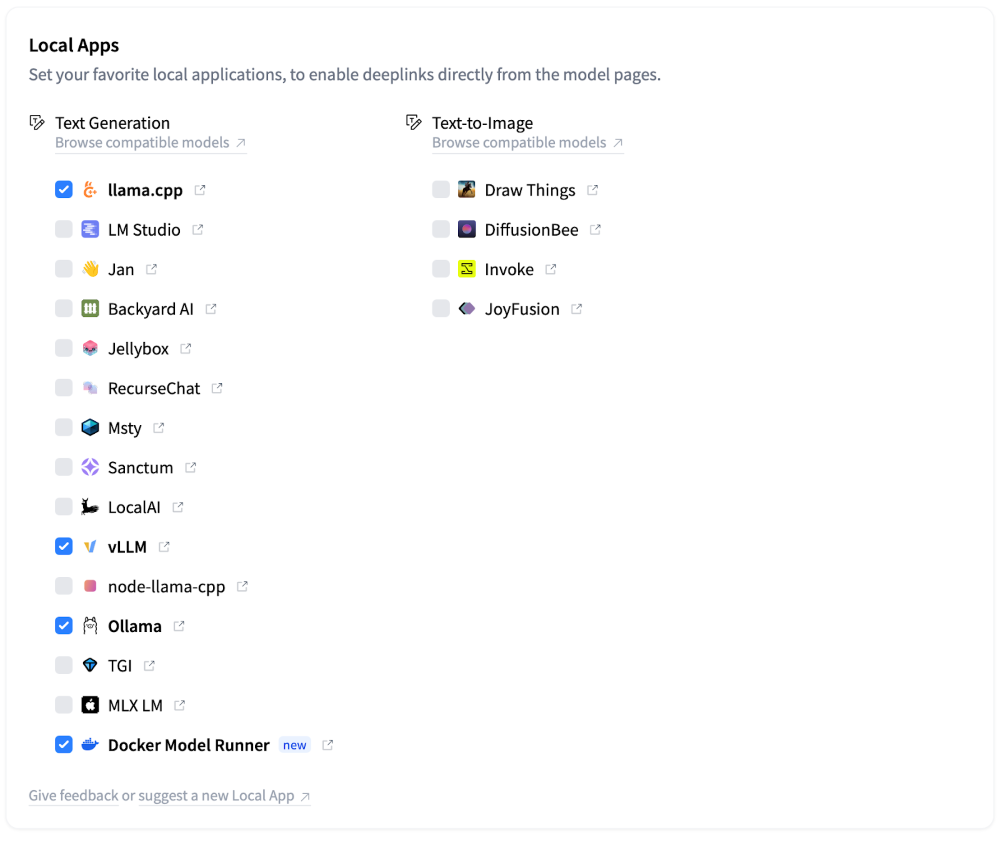

しかし、これまでのところ、Hugging Face で利用可能な膨大なモデルのコレクションを探し回ったり、Docker Model Runner で動作するリポジトリを見つけたりするのは面倒でした。しかし、もう違います!Hugging Face は Docker をローカル アプリ プロバイダーとしてサポートするようになったため、モデルを実行するためのローカル推論エンジンとして選択できます。また、アカウントで設定する必要さえありません。これは、すべてのユーザーのデフォルトのローカルアプリケーションプロバイダとしてすでに選択されています。

図 1:Docker Model Runnerは、Hugging Faceでローカルモデルを実行するための新しい推論エンジンです。

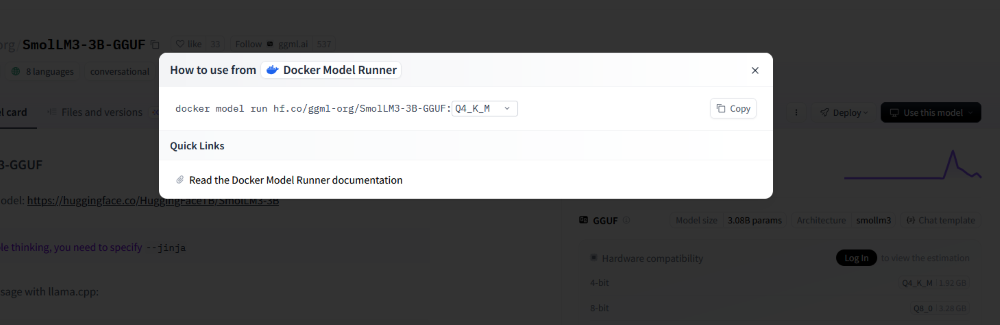

これにより、HuggingFace から直接モデルを実行するのは、リポジトリ ページにアクセスし、Local Apps プロバイダーとして Docker Model Runner を選択し、提供されたスニペットを実行するのと同じくらい簡単になります。

図 2: Docker Model Runner を使用して Hugging Face からモデルを実行するのが簡単になりました。

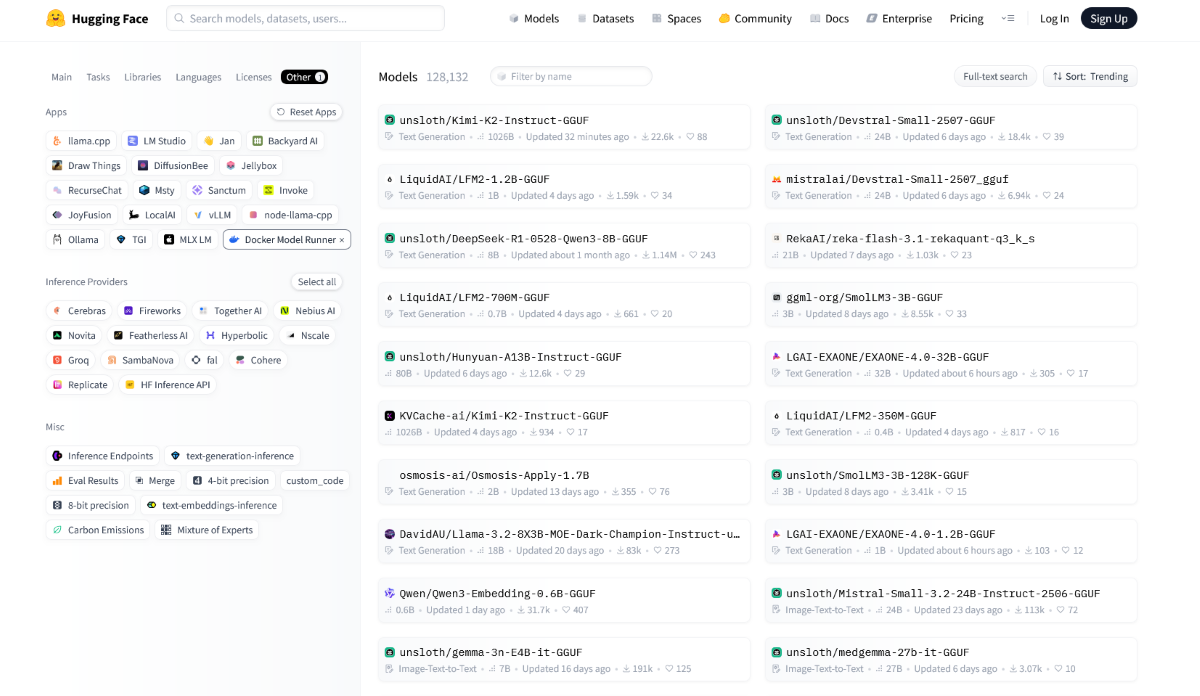

検索フィルターを使用して、Docker Model Runner でサポートされているすべてのモデル (GGUF 形式のモデルを含むリポジトリ) のリストを取得することもできます。

図 3:Hugging Faceの検索フィルターを使用して、Docker Model Runnerでサポートされているモデルを簡単に検出

HuggingFace が Docker Model Runner モデルのファーストクラスのソースとなり、モデルの発見がコンテナイメージのプルと同じくらい日常的になったことを非常に嬉しく思います。これは小さな変更ですが、リサーチと実行可能なコードの間の距離を静かに縮めるものです。

結論

Docker Model Runner が Hugging Face に直接統合されたことで、ローカル推論の実行がはるかに便利になりました。開発者は、互換性のあるモデルをフィルタリングし、1 つのコマンドでプルし、Docker Model Runner をローカル アプリ エンジンとして使用して Hugging Face UI から直接 run コマンドを取得できます。この緊密な統合により、モデルの検出と実行は、コンテナイメージをプルするのと同じくらいシームレスに感じられます。

Robert Axelrod 氏と The Evolution of Cooperation の話に戻りますが、Docker Model Runner は当初からオープンソース プロジェクトであり、コミュニティと一緒に構築することに関心があります。だから、GitHubに向かい、 リポジトリをチェックし、問題や提案を記録し、一緒に未来を築き続けましょう。

さらに詳しく

- Docker Offload Betaにサインアップすると、リソースを大量に消費するモデルをローカルのワークフローから直接、クラウドで300分間無料で実行できます。

- Docker Model Runner の設計アーキテクチャの内部をご覧ください。

- モデル分散仕様の背後にある ストーリー をご覧ください

- Docker Model Runner のクイックスタートガイドをお読みください。

- Model Runner のドキュメントが見つかります。

- 新しいAIソリューションのページをご覧ください

- Docker は初めてですか? アカウントを作成します。