どこかの研究室で午前 2 時です。研究者は 3 つの端末を開いており、一方の画面には半分書かれた Jupyter ノートブックがあり、別の画面にはサンプル ID が詰まった Excel シートがあり、シェル コマンドの横には半分食べたおやつが置かれています。彼らは、タンパク質フォールディングモデルを実行するためのスクリプトをやりくりし、前回の実験のCSVを解析し、文献を検索し、最新のアップデートでその1つのPythonパッケージが壊れたかどうかをグーグルで検索しています。

これは例外ではありません。それは標準です。今日の科学研究は、ツール、スクリプト、フォーマットのパッチワークであり、決意と深夜のカフェインによって接着されています。再現性はウィッシュリストの項目です。インフラは後回しです。自動化は存在しますが、通常は手で巻いて誰かのラップトップに貼り付けます。

しかし、科学ワークフローをインテリジェントエージェントによってエンドツーエンドで調整できるとしたらどうなるでしょうか?

科学者がシェルスクリプトを記述して依存関係が壊れないことを願う代わりに、「化合物やタンパク質のCSVを読み、文献を検索し、アドメットなど」という目標を説明し、AIエージェントが手順を計画し、コンテナ内の適切なツールを起動し、タスクを実行し、結果を要約できるとしたらどうなるでしょうか?

それが 科学エージェントの約束です。ChatGPT のように質問に答えるだけでなく、研究ワークフロー全体を自律的に実行する AI を活用したシステム。そして、LLM、GPU、Docker化された環境、オープンな科学ツールの融合のおかげで、この変化はもはや理論的ではありません。

それは今起こっています。

サイエンスエージェントとは何ですか?

サイエンス エージェントは、単なるチャットボットやスマート プロンプト ジェネレーターではありません。これは、人間の入力を最小限に抑えて、科学ワークフロー全体を計画、実行、反復するように設計された自律システムです。

「ADMETとは何ですか?」や「この論文を要約してください」などの1回限りの質問に頼るのではなく、科学エージェントはデジタル研究助手のように機能します。目標を理解し、ステップに分割し、適切なツールを選択し、計算を実行し、結果を反映します。

CrewAI: AI エージェント フレームワーク -> https://www.crewai.com/

ADMET:薬物がどのように吸収され、分布し、代謝され、排泄されるか、およびその毒性

具体的にしましょう。

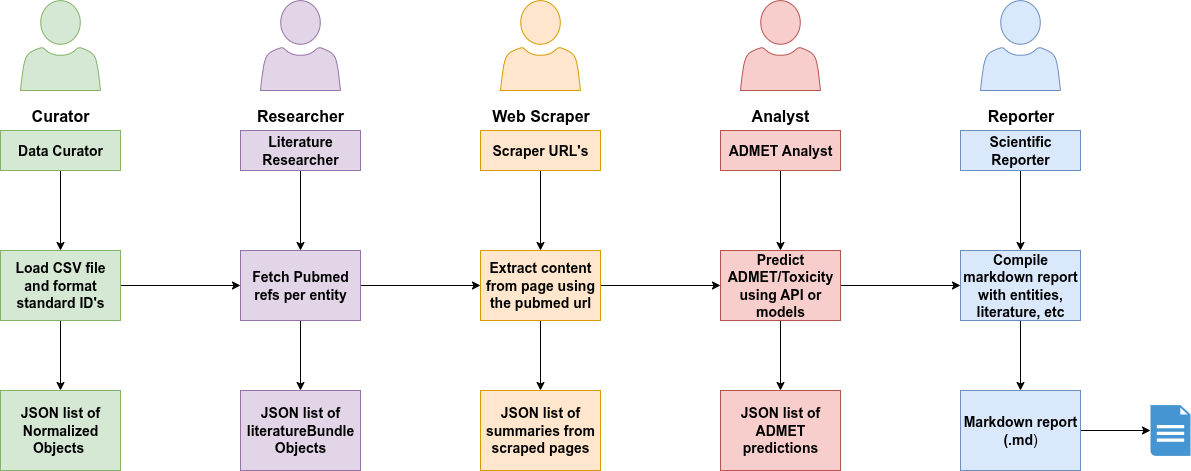

CrewAIで構築できるマルチエージェントシステムを考えてみましょう。

- キュレーター: データ品質と標準化を確保することを主な役割とするデータ重視のエージェント。

- 研究者:文学専門家。その主な目的は、キュレーターが提供する正規化されたエンティティの関連する学術論文をPubMedで見つけることです。

- Web スクレイパー: Web サイトから情報を抽出するための特殊なエージェント。

- アナリスト: モデルまたは API を使用して ADMET の特性と毒性を予測します。

- レポーター: すべての結果をクリーンな Markdown レポートにコンパイルします。

これらの各エージェントは独立して動作しますが、調整されたシステムの一部として機能します。これらを組み合わせることで、人間のチームでは数時間、場合によっては数日かかる作業を、今では数分で再現可能に自動化できます。

これがChatGPTと異なる理由

おそらく、論文の要約、Python コードの作成、または複雑なトピックの説明に ChatGPT を使用したことがあるでしょう。単純な質問と回答のエンジンのように見えるかもしれませんが、多くの場合、舞台裏ではプロンプト チェーン、コンテキスト ウィンドウ、推論の潜在的なループなど、さらに多くのことが起こっています。しかし、これらの進歩があっても、これらのやり取りは依然としてほとんどが人間関係にあります。

科学エージェントはまったく別の種です。

次のプロンプトを待つのではなく、ワークフロー全体を自律的に計画して実行します。コンテキストに基づいて使用するツール、結果の検証方法、ピボットするタイミングを決定します。ChatGPT が応答すると、エージェントが行動します。彼らはアシスタントというよりは、協力者のようなものです。

主な違いを詳しく見てみましょう。

|

特徴 |

LLM (ChatGPT など) |

サイエンスエージェント(CrewAI、LangGraphなど) |

|---|---|---|

|

相互作用 |

マルチターン、多くの場合、ユーザーのプロンプトまたはシステム指示によってガイドされます |

複数のツールにまたがる長期実行の自律的なワークフロー |

|

役割 |

エージェント機能が抽象化されたアシスタント |

役割固有のタスクを実行する明示的な研究協力者 |

|

自治 |

半自律型;外部プロンプトまたは組み込みシステムオーケストレーションが必要 |

完全自律的な計画、ツールの選択、反復 |

|

ツールの使用 |

一部のツールは、プラグイン/関数(ブラウザ、コードインタプリタなど)を介して使用されます |

明示的なツール統合(API、シミュレーション、データベース、Docker化されたツール) |

|

記憶 |

短期から中期のコンテキスト (セッションまたはチャットごとに制限、明示的でないワークスペース) |

永続的な長期メモリ(ベクトルDB、ファイルログ、データベース、明示的およびプログラム可能) |

|

再生可能性 |

エージェントの役割/タスクとそのツールを定義する機能がなく、非常に制限されています |

完全にコンテナ化されたバージョン管理されたワークフロー、定義されたエージェントの役割/タスクを使用した再現可能なワークフロー |

自分で試してみてください

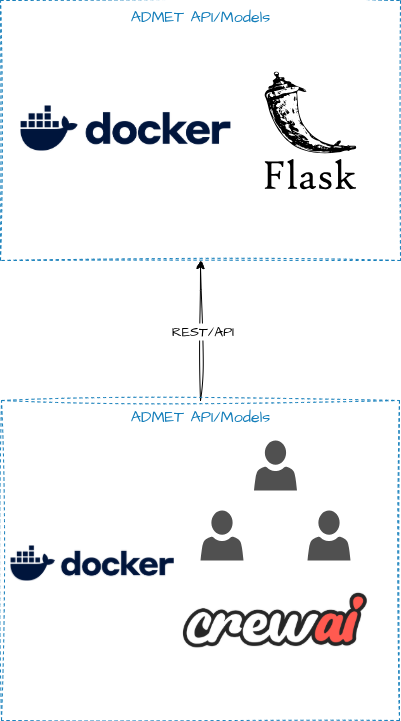

興味がある場合は、数分で実行できる 2 コンテナのデモをご紹介します。

gitリポジトリ: https://github.com/estebanx64/docker_blog_ai_agents_research

この例では、2つのコンテナ/サービスがあります。

前提 条件

- Docker と Docker Compose

- OpenAI API キー (GPT4o モデル アクセス用)

- 生物学的エンティティを含むサンプル CSV ファイル

リポジトリの README.md の指示に従って、OpenAI API キーを設定します

リポジトリに含まれる例を使用して次のワークフローを実行すると、OpenAI API に対して ~1-2 USD が請求されます。

ワークフローを実行します。

docker compose up

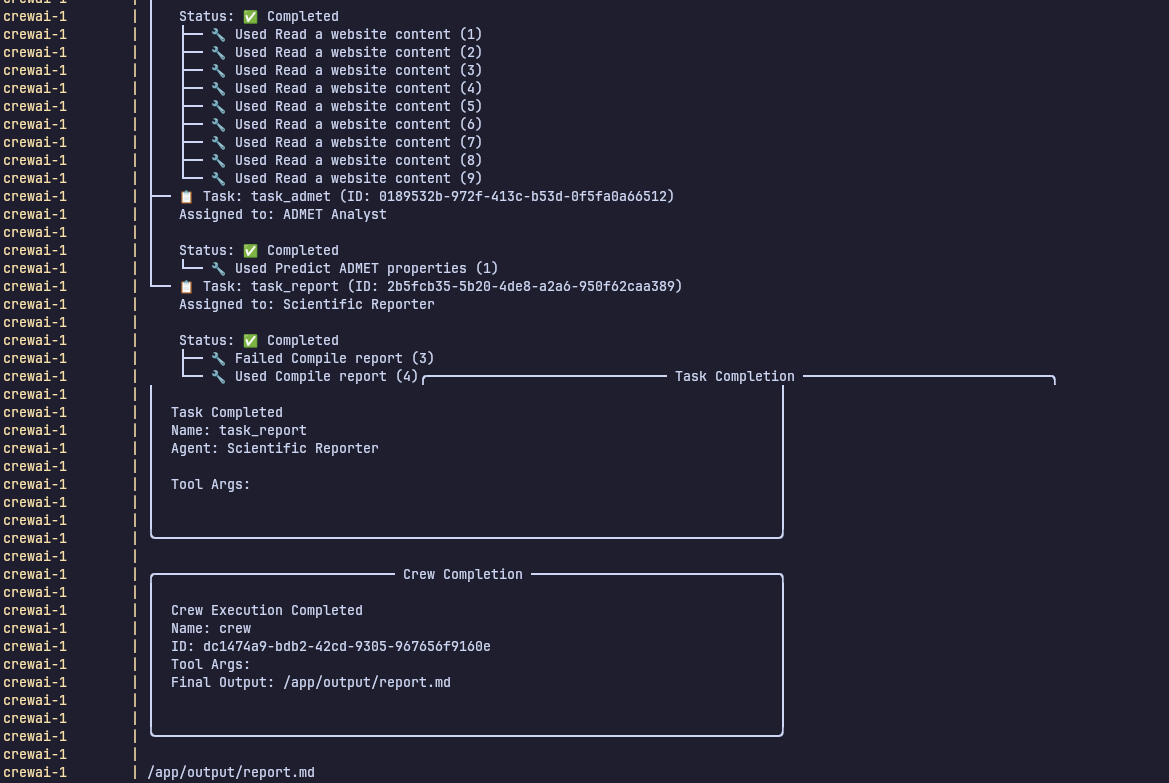

上記のログは、エージェントが完全なワークフローを自律的に計画して実行する方法を示しています。

CSVファイルの取り込み

- エージェントは、入力 CSV データセットをロードして解析します。

PubMed のクエリ

- 関連する科学論文を PubMed で自動的に検索します。

文献要約の生成

- 取得した記事は、簡潔で構造化された洞察に要約されます。

ADMETプロパティの計算

- エージェントは外部APIを呼び出して、ADMET(吸収、分布、代謝、排泄、毒性)の予測を計算します。

結果をMarkdownレポートにコンパイルする

- すべての調査結果は集約され、構造化された

report.mdにフォーマットされます。

出力ファイル

report.md– 包括的な調査レポート。- JSON ファイル – 正規化されたエンティティ、文献参照、ADMET 予測が含まれます。

これは、手動介入なしに意思決定を行い、ツールを使用し、タスクを調整するエージェントの能力を示しています。

さらに詳しく知りたい場合は、github リポジトリに含まれる README.md を確認してください

あなたの研究室が一晩で 100 実験を実行できるとしたら、最初に何を発見するかを想像してみてください。

しかし、このビジョンを実現するには、エージェントだけでなく、エージェントが実行する必要があるインフラストラクチャが難しいのです。

インフラストラクチャ: ボトルネック

AI サイエンス エージェントは強力ですが、適切なインフラストラクチャがなければ、すぐに壊れたり、拡張できなくなったりします。実際の研究ワークフローには、GPU、複雑な依存関係、大規模なデータセットが含まれます。ここで物事が困難になり、Docker が不可欠になります。

問題点

- 重いワークロード: AlphaFoldやBoltzなどのツールを実行するには、高性能GPUとスマートなスケジューリング(EKS、Slurmなど)が必要です。

- 再現性のカオス: 異なるシステム=壊れた環境。科学者は、科学を行う代わりに、ライブラリのデバッグに何時間も費やします。

- ツールチェーンの複雑さ: エージェントは、それぞれ独自の依存関係を持つ複数の科学ツール (RDKit、PyMOL、Rosetta など) に依存しています。

- バージョン管理地獄: 実行間でデータセット/モデルのバージョンを追跡することは、特にコラボレーションの場合、簡単ではありません。

コンテナが重要な理由

- 標準化された環境: ツールを一度パッケージ化すれば、ラップトップからクラウドまで、どこでも実行できます。

- 再現可能なワークフロー: エージェントのプロセスのすべてのステップがコンテナ化されているため、実験の再実行や共有が容易になります。

- コンポーザブルエージェント: 各ステップ (文献検索、折り畳み、ADMET 予測など) をコンテナ化されたサービスとして扱います。

- スムーズなオーケストレーション: CrewAI またはその他のフレームワークの機能を使用して、ホストを損なうことなく、コンテナをスピンアップし、出力コードの実行または検証が必要なタスクを分離できます。

オープンな課題と機会

科学エージェントは強力ですが、まだ初期です。開発者、研究者、ハッカーが大きな影響を与えることができる課題のリストは増えています。

未解決の問題点

- 長期記憶: 忘れっぽいエージェントは役に立ちません。時間の経過とともに科学的推論のために、より優れたセマンティックメモリシステム(ベクトルストア、ファイルログなど)が必要です。

- オーケストレーションフレームワーク: 複雑なワークフローには、堅牢なパイプラインが必要です。Temporal、Kestra、Prefect、そして友人たちは、バイオのゲームチェンジャーになるかもしれません。

- 安全性と限界自律性: エージェントの集中力を維持し、「幻覚科学」を避けるにはどうすればよいでしょうか?ガードレールはまだ欠けています。

- ベンチマークエージェント: 科学エージェントを比較するための基準はありません。現実世界の有用性を測定するには、タスク、データセット、指標が必要です。

貢献する方法

- より多くのツール (モデル、パイプライン、API) をコンテナ化して、エージェント システムにプラグインします。

- 科学領域におけるエージェントのパフォーマンスを評価するためのテストとベンチマークを作成します。

結論

私たちは新しい科学パラダイムの端に立っており、研究はAIによって加速されるだけでなく、AIと提携しています。科学エージェントは、断片的な作業の日々を、自律的で再現性のある大規模に実行されるオーケストレーションされたワークフローに変えています。

乱雑なシェルスクリプトやノートブックからコンテナ化されたインテリジェントなエージェントへの移行は、利便性だけではありません。それは、より多くの人に研究を開放し、発見サイクルを圧縮し、それが実行するモデルと同じくらい強力なインフラストラクチャを構築することです。

科学はもはや研究室に限定されません。コンテナで自動化され、GPU でスケジュールされ、あなたのような開発者によって出荷されています。

リポジトリをチェックして、独自の科学エージェントを構築してみてください。最初に自動化するワークフローは何ですか?