Docker Desktop 443 は、開発者が AI モデルと MCP ツールを実行、管理、および保護する方法を簡素化する一連の強力な更新プログラムをロールアウトしました。

Model Runner には、モデル管理の改善、OpenAI API 互換性の拡張、ランタイム動作のきめ細かな制御が含まれるようになりました。改善された MCP カタログにより、MCP サーバーの検索と使用が容易になり、独自の MCP サーバーの提出がサポートされるようになりました。一方、MCP Toolkit は、安全な認証のための組み込み OAuth サポートなど、VS Code および GitHub との統合を合理化します。Docker の AI エージェントである Gordon は、より高速で正確な応答を備えたマルチスレッド会話をサポートするようになりました。また、新しい Compose Bridge を使用すると、1 つのコマンドでローカルの compose.yaml ファイルを Kubernetes 構成に変換できます。

これらのアップデートにより、エージェントAIアプリの構築プロセスが効率化され、ローカル開発から本番環境への移行を容易にするDockerの継続的な取り組みのプレビューが提供されます。

Model Runner での新しいモデル管理コマンドと拡張された OpenAI API サポート

このリリースには、Docker Model Runner のユーザーインターフェース、推論 API、および内部の推論エンジンの改善が含まれています。

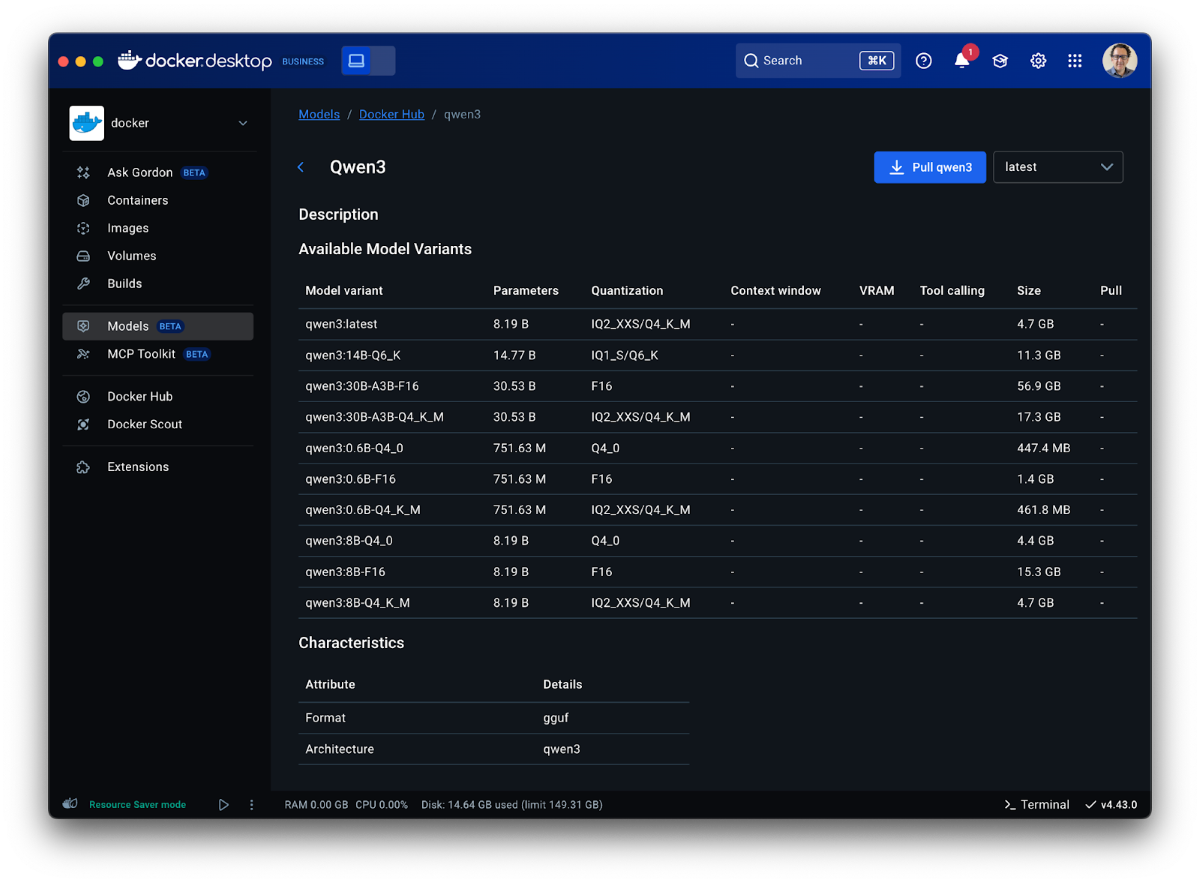

ユーザーインターフェースから始めて、開発者はDocker Desktopで直接利用可能なモデルカードを介してモデル(Docker Hubからすでに取得されたモデルや AIカタログでリモートで利用可能なモデルを含む)を検査できるようになりました。以下は、モデルカードがどのように表示されるかのスクリーンショットです。

図 1:モデルカードをDocker Desktopで直接表示して、モデルファミリー内のすべてのバリアントとその主な機能の概要を即座に把握します。

GUI の変更に加えて、 docker model コマンドには、開発者がモデルをより効果的に検査、監視、管理するのに役立つ 3 つの新しいサブコマンドが追加されています。

- docker model ps: 現在メモリにロードされているモデルを表示します

- docker model df: モデルと推論エンジンのディスク使用量を確認する

- docker model unload: モデルをメモリから手動でアンロードします (アイドル タイムアウトの前)

Docker Desktop 統合を有効にしている WSL2 ユーザーは、すべての docker モデル コマンドも WSL2 ディストリビューションから利用できるようになったため、Linux ベースのワークフローを変更せずにモデルを簡単に操作できるようになりました。

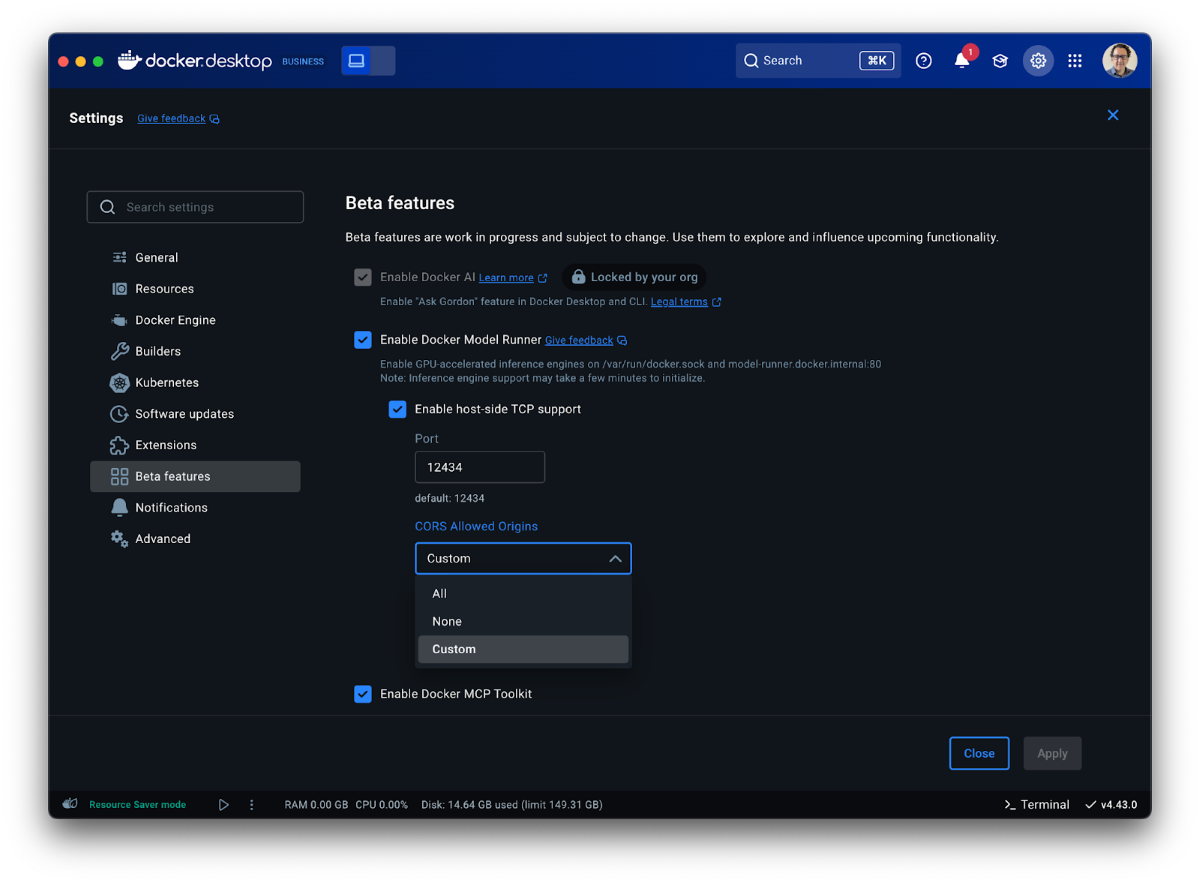

API 側では、Model Runner は追加の OpenAI API 互換性と構成可能性を提供するようになりました。具体的には、ツールが {"stream": "true"}でサポートされるようになり、Docker Model Runner上に構築されたエージェントの動的性と応答性が向上しました。Model Runner の API エンドポイントは、既存のツールとの互換性を高めるために OPTIONS 呼び出しをサポートするようになりました。最後に、開発者は Model Runner 設定ウィンドウで CORS オリジンを構成できるようになり、互換性とセキュリティの制御が向上しました。

図 2: CORS の許可されたオリジンが Docker Model Runner 設定で構成可能になったため、開発者は柔軟性と制御性を高めることができます。

モデルの動作をきめ細かく制御する必要がある開発者向けに、Docker Compose を使用してモデルのコンテキスト サイズや推論エンジンのランタイム フラグを設定する機能も導入しています。

models:

gemma3:

model: ai/gemma3

context_size: 8192

runtime_flags: ["--no-prefill-assistant"]

この例では、(オプションの) context-size パラメーターと runtime-flags パラメーターを使用して、その下にある推論エンジンの動作を制御しています。この場合、関連付けられているランタイムはデフォルト (llama.cpp) です。また、フラグのリストは ここにあります。特定のフラグは、Docker Desktop に付属する安定したデフォルト設定を上書きする場合がありますが、ユーザーが推論バックエンドを完全に制御できるようにしたいと考えています。また、特定のモデルアーキテクチャによって最大コンテキストサイズが制限される可能性があることにも注意してください。コンテキストの最大長に関する情報は、 Docker Hub の関連モデルカードで確認できます。

内部では、安定性と使いやすさの向上に注力してきました。推論プロセスがクラッシュした場合のエラー報告が改善され、クラッシュしたエンジンプロセスの削除がより積極的になりました。また、Docker CE の Compose での同時使用の処理を改善し、モデル プロバイダのサポートを強化することで、Docker CE Model Runner のエクスペリエンスを強化しました。

MCP Catalog & Toolkit:大規模な安全なコンテナ化されたAIツール

新しく再設計されたMCPカタログ

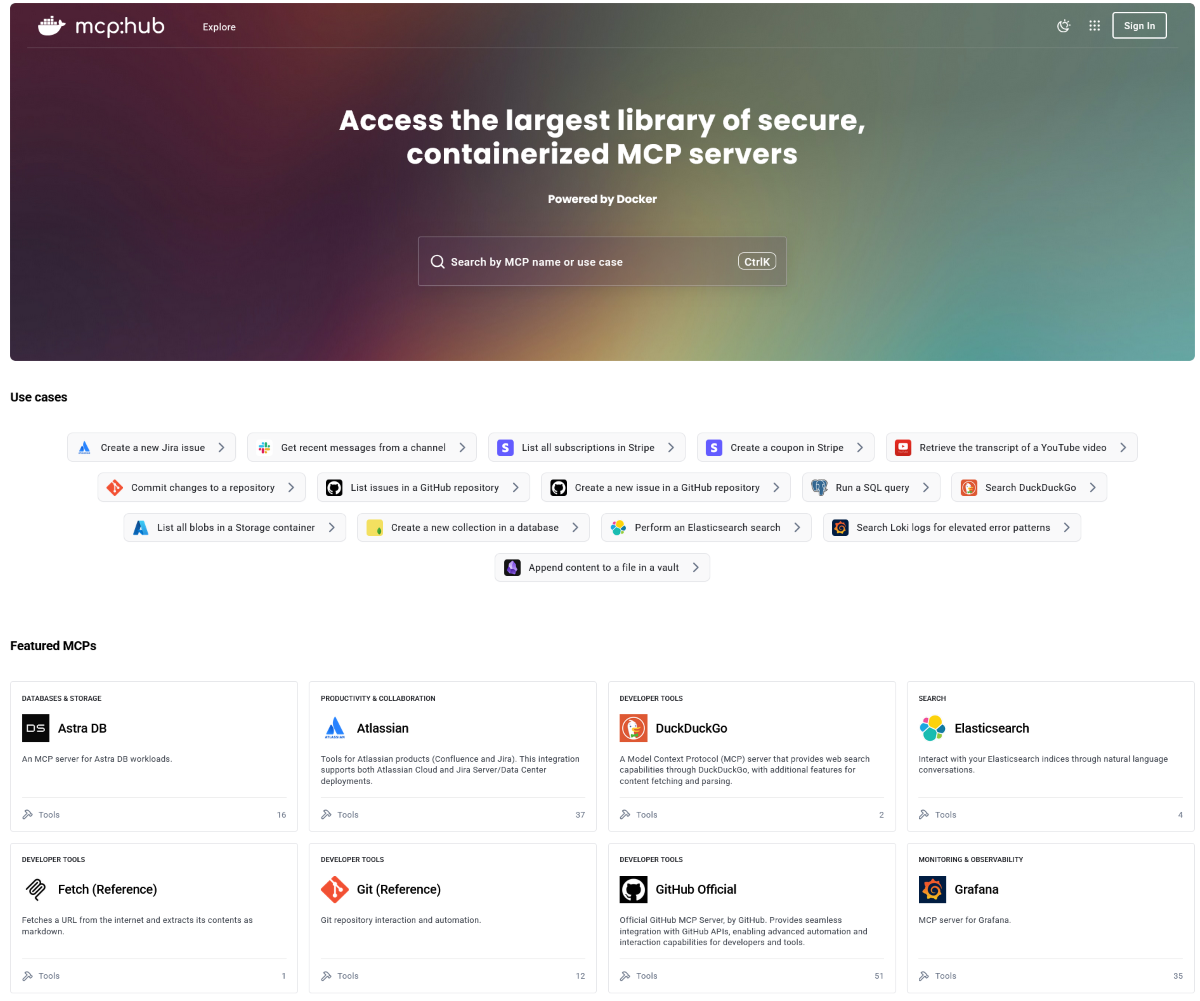

Docker の MCP カタログ のエクスペリエンスが向上し、ワークフローに適した MCP サーバーの検索、検出、特定が容易になりました。カタログには、Docker HubまたはDocker DesktopのMCP Toolkitから直接アクセスでき、 専用のWebリンク からもアクセスできるようになりました。

図 3:エージェントアプリケーションに適したMCPサーバーをすばやく見つけ、新しいカタログを使用して特定のユースケースで参照します。

MCPカタログには現在、検証済みのコンテナ化されたツールが 100 以上含まれており、さらに数百のツールが近日公開される予定です。ホスト上で直接コードを実行する従来の npx や uvx ワークフローとは異なり、カタログ内のすべての MCP サーバーは分離された Docker コンテナ内で実行されます。それぞれに、暗号化署名、ソフトウェア部品表 (SBOM)、および出所証明が含まれています。

このアプローチにより、未検証のコードを実行するリスクが排除され、プラットフォーム間で一貫性のある再現可能な環境が確保されます。データベースコネクタ、API統合、開発ツールのいずれが必要な場合でも、MCPカタログは、AIを活用した開発ワークフローのための信頼できるスケーラブルな基盤を提供し、エコシステム全体をリスクの高い実行パターンから本番環境に対応したコンテナ化されたソリューションへと移行します。

MCP サーバーを Docker MCP カタログに提出する

新しい提出プロセスを開始し、開発者に こちらのプロセスに従うことで貢献するための柔軟なオプションを提供します。開発者は、Docker ビルド サーバーとコミュニティビルド サーバーの 2 つのオプションから選択できます。

Docker ビルドのサーバー

「Built by Docker」と表示されている場合は、完全なセキュリティ処理を受けています。ビルドパイプライン全体を制御し、暗号化署名、SBOM、来歴証明、および継続的な脆弱性スキャンを提供します。

コミュニティ構築サーバー

これらのサーバーは、開発者によって Docker イメージとしてパッケージ化されています。私たちは彼らのビルドプロセスを制御していませんが、コンテナの分離は依然として有益であり、これは直接実行よりも大幅にセキュリティが向上しています。

Docker で構築されたサーバーはセキュリティのゴールド スタンダードであり、コミュニティで構築されたサーバーにより、開発者の要求に合わせて迅速に拡張できます。開発者は、コミュニティが構築したサーバーを提出した後で考えを変え、Docker で構築されたサーバーとして再提出することを選択できます。

今すぐ Docker MCP カタログに MCP サーバーを取り上げ、 20 00 万人以上の開発者にリーチしましょう。新しい MCP カタログの詳細については、お知らせ ブログ でご覧いただき、MCP サーバーの構築、実行、テストに関する ベスト プラクティス に関する洞察をご覧ください。安全でコンテナ化されたMCPサーバーの最大のライブラリの構築にご参加ください! . .

MCP Toolkit に OAuth サポートが追加され、GitHub および VS Code との統合が効率化されました

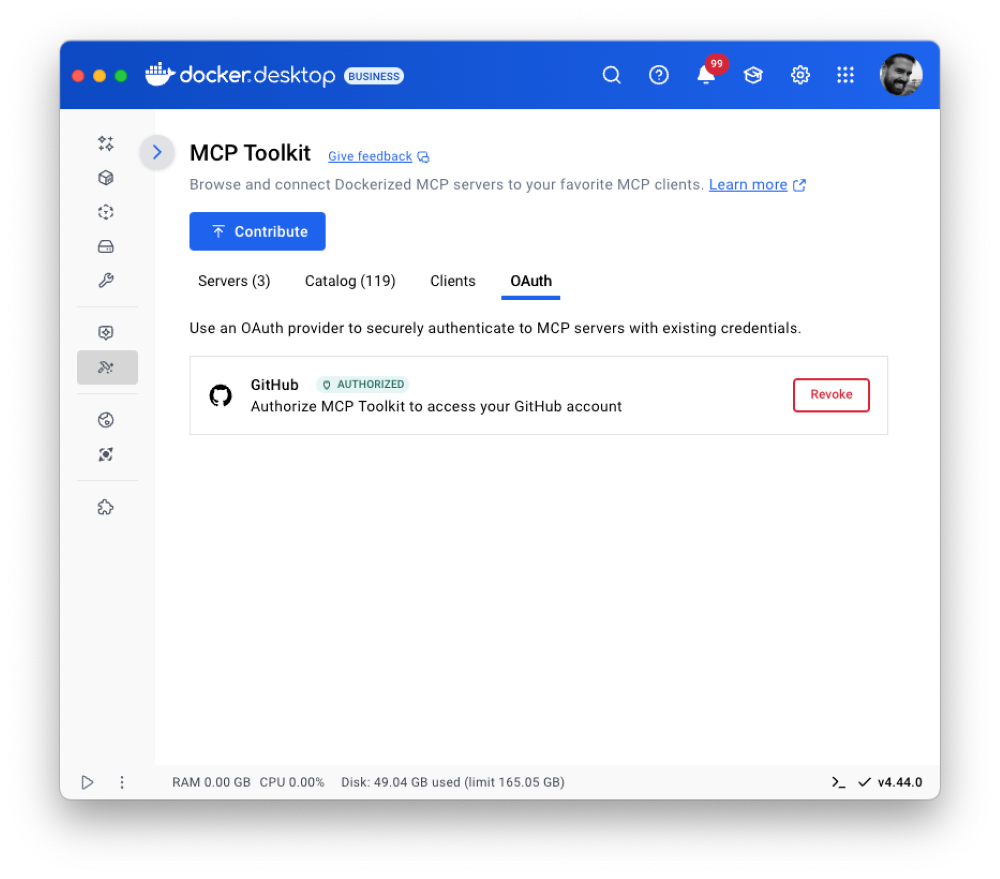

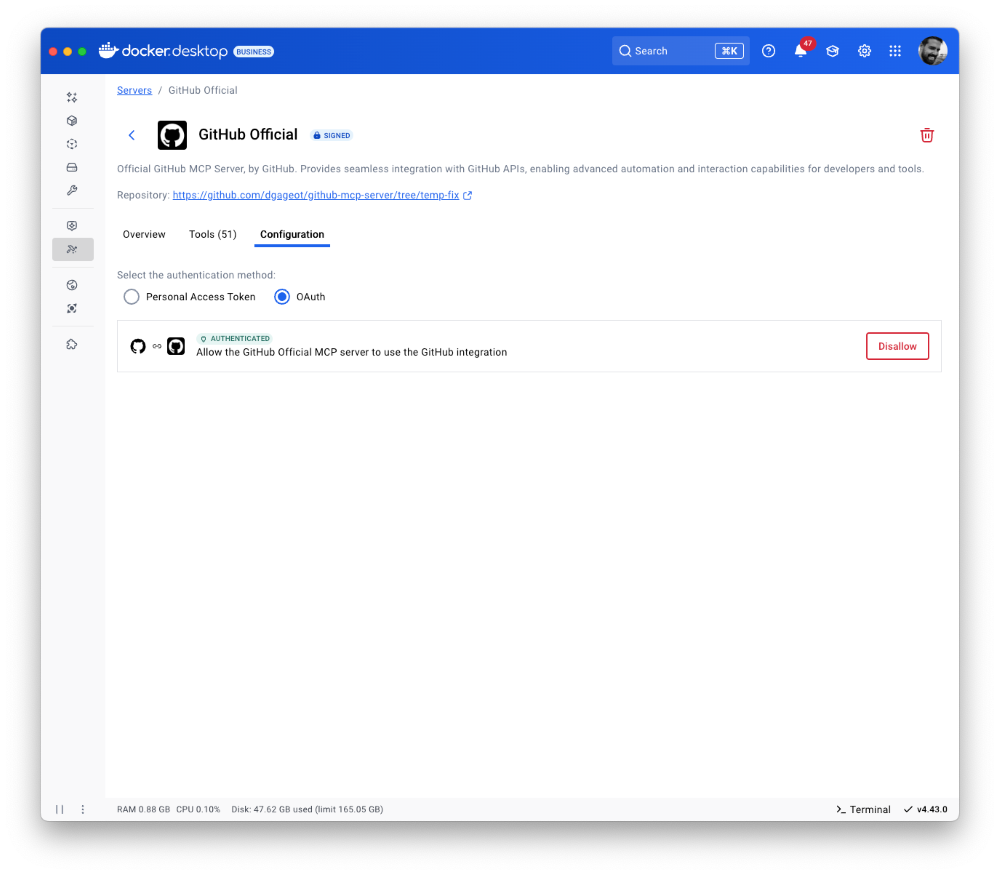

多くのMCPサーバーの認証情報はプレーンテキストの環境変数として渡されるため、機密データが公開され、漏洩のリスクが高まります。MCP Toolkitは、安全な認証情報ストレージによりそのリスクを排除し、クライアントがシークレットをハードコーディングすることなくMCPサーバーやサードパーティサービスで認証できるようにします。OAuthのサポートでは、最も広く使用されている開発者ツールであるGitHubから始めて、さらに一歩進んでいます。これにより、安全な認証を開発ワークフローにさらに簡単に統合できます。

図 4: OAuth が GitHub MCP サーバーでサポートされるようになりました。

GitHub MCP サーバーを設定するには、[OAuth] タブに移動し、GitHub アカウントを接続してサーバーを有効にし、安全な認証のために OAuth を承認します。

図 5: GitHub MCP サーバーの構成タブに移動して、安全な認証のために OAuth を有効にします

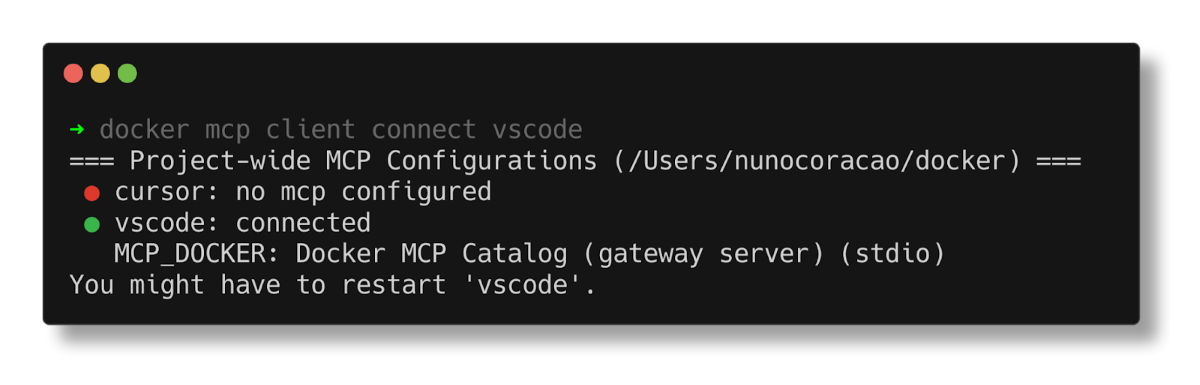

MCP Toolkit を使用すると、MCP サーバーを任意の MCP クライアントに接続でき、Claude や Cursor などの一般的なクライアントにワンクリックで接続できます。また、開発者が docker mcp client connect vscode コマンドを使用して VSCode に簡単に接続できるようにしています。プロジェクトのルート フォルダーで実行すると、mcp.json構成ファイルが .vscode に作成されますフォルダ。

図 6: CLI の MCP コマンドを使用した VS Code への接続

さらに、ユーザー設定に次の構成を追加することで、MCP Toolkit を VSCode で使用できるグローバル MCP サーバーとして構成することもできます。詳細については、 このドキュメント をご覧ください。接続すると、リポジトリ、問題、プルリクエストへのフルアクセスでエージェントモードでGitHub Copilotを活用できます。

"mcp": {

"servers": {

"MCP_DOCKER": {

"command": "docker",

"args": [

"mcp",

"gateway",

"run"

],

"type": "stdio"

}

}

}

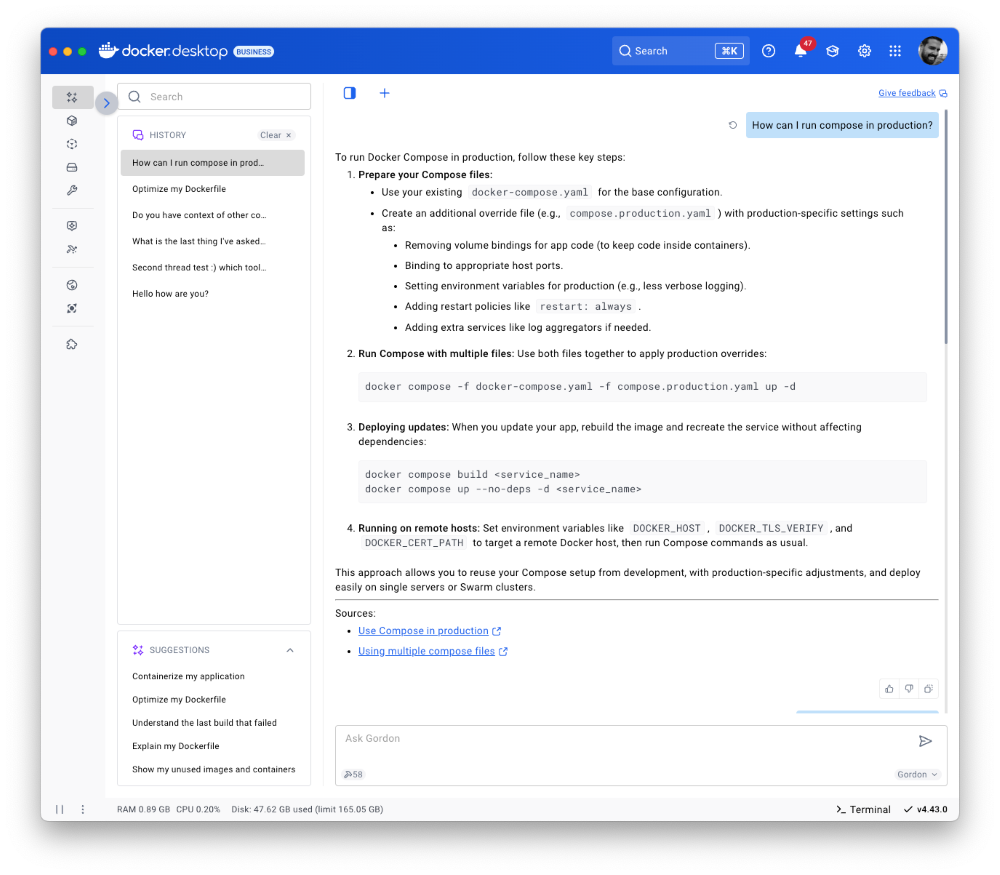

Gordon がさらに賢くなる: マルチスレッドの会話と 5x 速さのパフォーマンス

Docker の AI Agent Gordon は、マルチスレッドの会話サポートという大幅なアップグレードを行いました。複数の異なる会話を並行して実行し、1 つのスレッドでコンテナの問題をデバッグしたり、別のスレッドで Docker Compose セットアップを改良したりするなどのトピックを、コンテキストを失うことなく切り替えることができるようになりました。Gordon は各スレッドを整理してくれるので、中断した会話からすぐに再開できます。

Gordonの新しいマルチスレッド機能は、MCPツールと連携して動作し、開発ワークフローを強力に後押しします。Gordonをお気に入りのMCPツールと一緒に使用することで、タスクごとに会話を整理しながら、状況に応じたヘルプを得ることができます。コンテキストの切り替えにフォーカスを失うことはもうありません。

図 7:Gordonの新しいマルチスレッドサポートにより、コンテキストの切り替えが削減され、生産性が向上します。

また、パフォーマンスの大幅なアップグレードも展開し、Gordon は 5倍速く応答し、より正確でコンテキストに応じた回答を提供するようになりました。Docker 固有のコマンド、構成、およびトラブルシューティング シナリオの理解が深まったことで、Gordon はこれまで以上に賢く、より便利になりました。

Compose Bridge: ローカルの Compose から Kubernetes にシームレスに移行

Docker Compose は、シンプルで理解しやすいため、開発者がローカル環境の管理に好意を寄せていることを私たちは知っています。このたび、Compose Bridge が Docker Desktop に導入されました。この新しい強力な機能により、1 つのコマンドでローカルの compose.yaml を Kubernetes 構成に変換できます。

ComposeをKubernetesに数秒で変換

Compose Bridge は、Compose アプリケーションを Kubernetes に取り込むための合理的で柔軟な方法を提供します。スマートなデフォルトとカスタマイズのオプションにより、シンプルなセットアップと複雑なマイクロサービスアーキテクチャの両方をサポートするように設計されています。

必要なのは、以下の通りです。

docker compose bridge convert

このように、Compose Bridge は Compose ファイルから次の Kubernetes リソースを生成します。

- デプロイメントを分離するための名前空間

- すべての Compose 設定エントリの ConfigMap

- サービスの実行とスケーリングのためのデプロイ

- 公開ポートおよび公開ポートのサービス (ホスト アクセス用の LoadBalancer サービスを含む)

- Secrets for your Compose file (ローカル使用用にエンコード) 内のシークレット

- Compose ネットワーク トポロジを反映する NetworkPolicies

- PersistentVolumeClaims は Docker Desktop の hostpath ストレージを使用します。

このアプローチでは、ローカルの開発環境を Kubernetes で迅速かつ正確にレプリケートするため、本番環境のような条件でより迅速にテストできます。

組み込みの柔軟性と今後の機能強化

もっとカスタマイズされたものが必要ですか?Compose Bridge は高度な変換オプションをサポートしているため、サービスのマッピング方法を微調整したり、結果として得られる構成をインフラストラクチャに合わせて調整したりできます。

今後のリリースでは、Compose Bridge が既存のクラスタ設定に基づいて Kubernetes 設定を生成できるようになるため、チームはマニフェストをゼロから書き直すことなく、開発と本番環境を連携させることができます。

今すぐ始める

Compose Bridge は、本日からご利用いただけます。

- Docker Desktop のダウンロードまたは更新

- ターミナルを開き、次のコマンドを実行します。

- ドキュメントを確認して、カスタマイズ オプションを確認します

docker compose bridge convert

結論

Docker デスクトップ 4.43 では、AI とクラウドネイティブ アプリが交差する場所で構築する開発者向けの実用的なアップデートを紹介しています。ローカル モデルの実行、安全な MCP サーバーの検索と実行、マルチスレッド AI アシスタンスのための Gordon の使用、Compose ファイルの Kubernetes への変換など、このリリースでは複雑さが軽減され、シッピングに集中できます。エージェント AI プロジェクトから、ローカルから本番環境へのワークフローのスケーリングまで、全体を通じて、より制御しやすく、統合がスムーズになり、手動のステップが少なくなります。

さらに詳しく

- 新しいMCPカタログの詳細をご覧ください。

- MCP サーバーを MCP カタログに送信します。

- 今すぐ認証して更新すると、サブスクリプション レベルの最新の Docker Desktop 機能を利用できます。

- Docker Navigator ニュースレターを購読してください。

- 詳しくは、サインインの強制オプションをご覧ください。

- Docker は初めてですか? アカウントを作成します。

- ご質問はございますか? Docker コミュニティがお手伝いします。